-

九木酒

九木酒

- 第三种情况比第一种情况多了个update_time<now()条件,丢失的数据不是应该更多吗

- 2025-08-07 0回答·42浏览

-

weixin_慕数据9518735

weixin_慕数据9518735

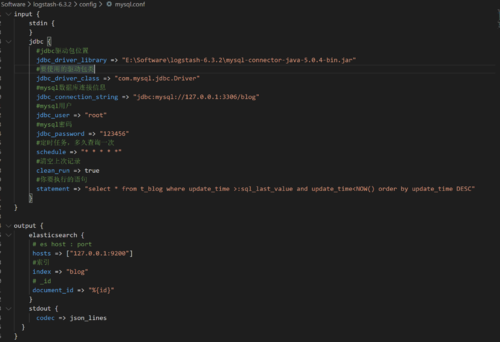

- 自己新增了一个mysql.conf 文件 , logstash -f ../config/mysql.conf 同步 报错 没看懂啥错

- 2023-12-04 0回答·267浏览

-

一娆Hacker

一娆Hacker

- 下载的logstash 的config目录下没有mysql的配置文件呀

使用这个案例模板文件重新命名

logstash-sample.conf- 2022-04-16 1回答·585浏览

-

木头年糕

木头年糕

- 最终的过滤条件不应该是update_tim >=:sql_last_value and update_time < Now()么?

个人理解确实应该是 `>=`. 前文配置时也是 `>=`

- 2022-04-15 1回答·492浏览

-

逆流的鱼_飞

逆流的鱼_飞

- mysql.conf执行失败,貌似是编码的原因,我改成utf-8格式的还是报错,报错信息如下,有遇到的么

改成ansi格式,不要有中文备注

- 2022-01-20 1回答·436浏览

-

慕虎7405414

慕虎7405414

- logstash启动不起来,报错logstash.bat : Ҳ Active

- 2022-01-15 0回答·366浏览

-

qq_慕田峪5029356

qq_慕田峪5029356

- 为什么需要添加条件updata_time<NOW() ?

假设第一次扫描结束时,时间节点为t1,而且这个时间节点有两条数据A和B,其中B没扫到,如果后面还是按大于t1扫描,就会漏掉B。

如果我们的策略是第一次扫描直接放弃t1时间节点的数据,即update_time<now()。这样下次扫描就可以扫到了,因为sql_last_value是小于t1的,update_time>:sql_last_value就包含了A和B。

简而言之,往前看一个步骤就可以理解了。

- 2021-09-10 2回答·636浏览

-

网络时空

网络时空

- update_time >:sql_last_value AND update_time < NOW()写法没有等号可能漏掉一些增量

- 2021-07-16 1回答·616浏览

-

网络时空

网络时空

- 求视频中对应的Logstash对应的conf目录中的mysql.conf文件

input {

jdbc {

jdbc_driver_library => "D:\\data_of_programming\\L2R\\ElasticSearch\\logstash-6.3.2\\mysql-connector-java-5.1.44.jar"

jdbc_driver_class => "com.mysql.jdbc.Driver"

jdbc_connection_string => "jdbc:mysql://localhost:3306/blog?serverTimezone=UTC&characterEncoding=utf8"

jdbc_user => "root"

jdbc_password => "root"

# 定时任务,默认一分钟,"* * * * *"代表设置为无延迟

schedule => "* * * * *"

# 清空上一次sql_last_value记录

clean_run => true

statement => "SELECT * FROM t_blog"

}

}

output {

elasticsearch {

hosts => ["127.0.0.1:9200"]

index => "blog"

document_id => "%{id}"

}

}

- 2021-07-16 3回答·791浏览

-

慕粉4349782

慕粉4349782

- 全量导入oracle的数据会遗漏数据

那是计算上有误差吧

- 2021-02-05 1回答·621浏览

-

Sea_l

Sea_l

- 无法启动 百度也没有解决 求大神指导一下

- 另外还得注意jdk版本,我从jdk11改成jdk8后就能启动了。

- 2020-10-21 6回答·980浏览

-

qq_慕田峪8388513

qq_慕田峪8388513

- 无法执行命令logstash.bat -f …/config/mysql.conf

这个问题在bin文件夹中的logstash.bat启动文件 打开 修改里边的%CLASSPATH% 改成"%CLASSPATH%" 大概在55行左右 源文件内容 %JAVA% %JAVA_OPTS% -cp %CLASSPATH% org.logstash.Logstash %* 修改成%JAVA% %JAVA_OPTS% -cp "%CLASSPATH%" org.logstash.Logstash %*

- 2020-06-04 2回答·1251浏览

-

慕码人0215510

慕码人0215510

- 为什么报错呀

看看你的表有没有update_time这个字段

- 2020-05-31 1回答·855浏览

-

Cheery3381498

Cheery3381498

- logstash怎么和springboot项目结合一起用的

- 2020-04-29 1回答·1056浏览

-

空指针1

空指针1

- 网上下载的配置文件换行有问题,分享一份我本地修改后的配置

+1~

- 2020-04-23 1回答·903浏览

-

qq__inruIR

qq__inruIR

- logstash -f ../config/mysql.conf报错异常怎么解决

网上复制的配置文件格式有问题,和我一样,重新换行一下就可以了

- 2020-04-22 1回答·1139浏览

-

慕九州43954899

慕九州43954899

- 项目无法启动

+1~

- 2020-04-21 1回答·803浏览

-

空指针1

空指针1

- 最后的筛选SQL条件应该改为:update_time>=sql_last_value and update_time<now()

假如2022:01:01 00:01插100条第一次搜

>1979:01:01 00:00 < 2022:01:01 00:01你可能根本就搜不出来,因为条件是少于当时系统时间00:01

其实就是搜索了

>1979:01:01 00:00 < 2020:01:01 00:00这个范围而已所以这时候插入的数据根本没匹配到数据

注意这里保存的时间点可能是00:00,但绝对不是00:01所以第二次搜的时候是>00:00而不是>00:01

>2022:01:01 00:00 < 2022:05:05 00:01

这里为什么是00:00而不是00:01呢,因为第一次搜的时候是记录<少于不是=的时间点

其实老师这个语法只是把当前时间插入的100条数据放弃搜索不处理而是供给下次执行搜索的范围做条件

- 2020-04-21 4回答·2064浏览

-

Emrnest

Emrnest

- mysql.conf如图,但是控制台执行命令报错

重新编写SQL,ok

- 2020-04-11 2回答·1097浏览

-

慕娘4521734

慕娘4521734

- logstash启动后走了几行程序就不动了是怎么回事啊?

- 2020-03-29 2回答·1462浏览

-

阿飞的课

阿飞的课

- logstash 只能同步增加的数据,不能同步更新和删除的数据

是必须要有update_time这个字段才能同步更新吗 其他能同步更新不

- 2020-03-17 3回答·4157浏览

-

慕慕9165351

慕慕9165351

- 日志不打印sql语句怎么回事配置不对吗

- 2020-01-19 2回答·1260浏览

-

_冬阳

_冬阳

- 请问一下老师的这个sql语句是什么意思?

表示最后一次执行查询的时间。

- 2020-01-10 1回答·820浏览

-

_冬阳

_冬阳

- 同步到es后和数据库的条数不一致

ES的数据条数在下面啊,docs里面的count才是,你截图的是集群数量?

- 2020-01-10 2回答·1967浏览

-

慕仔147898

慕仔147898

- 我的 logstash 报警告不执行

这个原因是环境变量的问题 不是jvm的问题

- 2020-01-03 1回答·929浏览

-

_学渣

_学渣

- 用logstash同步数据报错,咋回事?

- 2019-12-09 4回答·1065浏览

-

邪墨羽

邪墨羽

- [logstash.agent ] Successfully started Logstash API endpoint {:port=>9600}

- 2019-12-09 4回答·1717浏览

-

上帝star3252970

上帝star3252970

- mysql的源数据

CREATE DATABASE ems;

USE ems;

CREATE TABLE `t_blog` (

`id` int(11) NOT NULL AUTO_INCREMENT COMMENT '自增id',

`title` varchar(60) DEFAULT NULL COMMENT '博客标题',

`author` varchar(60) DEFAULT NULL COMMENT '博客作者',

`content` mediumtext COMMENT '博客内容',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '更新时间',

PRIMARY KEY (`id`)

) ENGINE=InnoDB AUTO_INCREMENT=9 DEFAULT CHARSET=utf8mb4

# 自己造的几条数据

INSERT INTO `ems`.`t_blog`(`id`, `title`, `author`, `content`, `create_time`, `update_time`) VALUES (1, 'Springboot 为什么这', 'bywind', '没错 Springboot ', '2019-12-08 01:44:29', '2019-12-08 01:44:34');

INSERT INTO `ems`.`t_blog`(`id`, `title`, `author`, `content`, `create_time`, `update_time`) VALUES (3, 'Springboot 中 Redis', 'bywind', 'Spring Boot', '2019-12-08 01:44:29', '2019-12-08 01:44:29');

INSERT INTO `ems`.`t_blog`(`id`, `title`, `author`, `content`, `create_time`, `update_time`) VALUES (4, 'Springboot 中如何优化', 'bywind', NULL, '2019-12-08 01:44:29', '2019-12-08 01:44:29');

INSERT INTO `ems`.`t_blog`(`id`, `title`, `author`, `content`, `create_time`, `update_time`) VALUES (5, 'Springboot 消息队列', 'bywind', NULL, '2019-12-08 01:44:29', '2019-12-08 01:44:29');

INSERT INTO `ems`.`t_blog`(`id`, `title`, `author`, `content`, `create_time`, `update_time`) VALUES (6, 'Docker Compose + Springboot', 'bywind', NULL, '2019-12-08 01:44:29', '2019-12-08 01:44:29');

- 2019-12-01 2回答·879浏览

-

weixin_慕斯卡4051624

weixin_慕斯卡4051624

- 数据导不进来, 求教

老哥求一份t_blog的数据

- 2019-12-01 1回答·819浏览

-

慕仰8306696

慕仰8306696

- statement只操作了一张表啊,如果像操作2张表怎么办

两种解决方案:

1. 先操作一张表 然后再操作另外一张表 最后组合两张表的数据2. 两张表关联查询【数据库可以】

- 2019-11-21 1回答·680浏览