-

- 霜花似雪 2022-08-07

grouping:

随机发送

按一定规则发送

strom: kafka-->数据源结点spout多个(数据来源,发送一个个Tuple给到bolt,同样的Tuple会发到同样的bolt),普通计算结点bolt(可调用其它语言脚本,如java,python)多个(计算完可以持久化到数据库),数据流stream,记录Tuple。

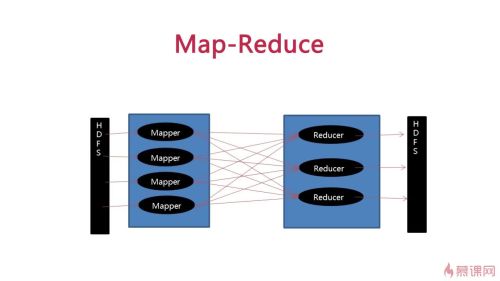

Hdfs: Mapper从hdfs中读取数据并计算,进行整理后(同一个word一定落到同一个reduce里)发送给reduce-再发送给hdfs- 0赞 · 0采集

-

- 小邪尊 2018-12-13

我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13

我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13

我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13

我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13

我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13我的笔记test13

- 0赞 · 0采集

-

- 小邪尊 2018-12-13

我的笔记test13

- 0赞 · 0采集

-

- 小邪尊 2018-12-13

我的笔记test12

- 0赞 · 0采集

-

- 小邪尊 2018-12-13

我的笔记test11

- 0赞 · 0采集

-

- 小邪尊 2018-12-13

我的笔记test10

- 0赞 · 0采集

-

- 小邪尊 2018-12-13

我的笔记test9

- 0赞 · 0采集

-

- 小邪尊 2018-12-13

我的笔记test8

- 0赞 · 0采集

-

- 小邪尊 2018-12-13

我的笔记test7

- 0赞 · 0采集

-

- 小邪尊 2018-12-13

我的笔记test6

- 0赞 · 0采集

-

- 小邪尊 2018-12-13

我的笔记test5

- 0赞 · 0采集

-

- 小邪尊 2018-12-13

我的笔记test4

- 0赞 · 0采集

-

- 小邪尊 2018-12-13

我的笔记test3

- 0赞 · 0采集

-

- 凡简 2018-12-11

Map-Reduce

-

截图0赞 · 0采集

-

- shenhengtong 2018-12-06

作业=Topology?

-

截图0赞 · 0采集

-

- 暗淡蓝点6730 2018-01-01

- Mapreduce的组成示例

-

截图0赞 · 1采集

-

- 暗淡蓝点6730 2018-01-01

- 处理过程示例图

-

截图0赞 · 1采集

-

- 暗淡蓝点6730 2018-01-01

- Spout、Bolt、Stream、Tuple

-

截图0赞 · 1采集

-

- 路过28 2017-04-24

- Spout、Bolt、Stream、Tuple

-

截图0赞 · 0采集

-

- 慕粉3429060 2017-04-16

- Map-Reduce计算Words2

-

截图0赞 · 0采集

-

- 慕粉3429060 2017-04-16

- Map-Reduce计算Words

-

截图0赞 · 0采集

-

- Feater 2017-02-01

- Map_reduce

-

截图0赞 · 0采集

-

- Feater 2017-02-01

- Mapreduce的组成

- 0赞 · 0采集

-

- Feater 2017-02-01

- 数据的分组方式

- 0赞 · 0采集

-

- Feater 2017-02-01

- Storm构成图

- 0赞 · 0采集

-

- ymvkujn 2016-12-21

- strom: kafka-->数据源结点spout多个(数据来源,发送一个个Tuple给到bolt,同样的Tuple会发到同样的bolt),普通计算结点bolt(可调用其它语言脚本,如java,python)多个(计算完可以持久化到数据库),数据流stream,记录Tuple。 Hdfs: Mapper从hdfs中读取数据并计算,进行整理后(同一个word一定落到同一个reduce里)发送给reduce-再发送给hdfs

- 0赞 · 1采集

-

- 积淀123 2016-07-13

- 组成

-

截图0赞 · 1采集

-

- 积淀123 2016-07-13

- 组成图

- 0赞 · 0采集

-

- 积淀123 2016-07-13

- 组成

- 0赞 · 0采集

-

- billkeith 2016-04-15

- topology的组成

-

截图0赞 · 1采集