-

- 超人归来2020 2025-08-01

- 什么是语言建模

- 0赞 · 0采集

-

- 一不不 2025-02-07

大模型入门

大模型(Large Language Models ,LLM)是指拥有数十亿或数百亿个参数的大型预训练语言模型,如GPT系列模型。它们在解决各种自然语言处理任务方面表现出强大的能力,甚至可以展现出一些小规模语言模型所不具备的特殊能力,如涌现能力。

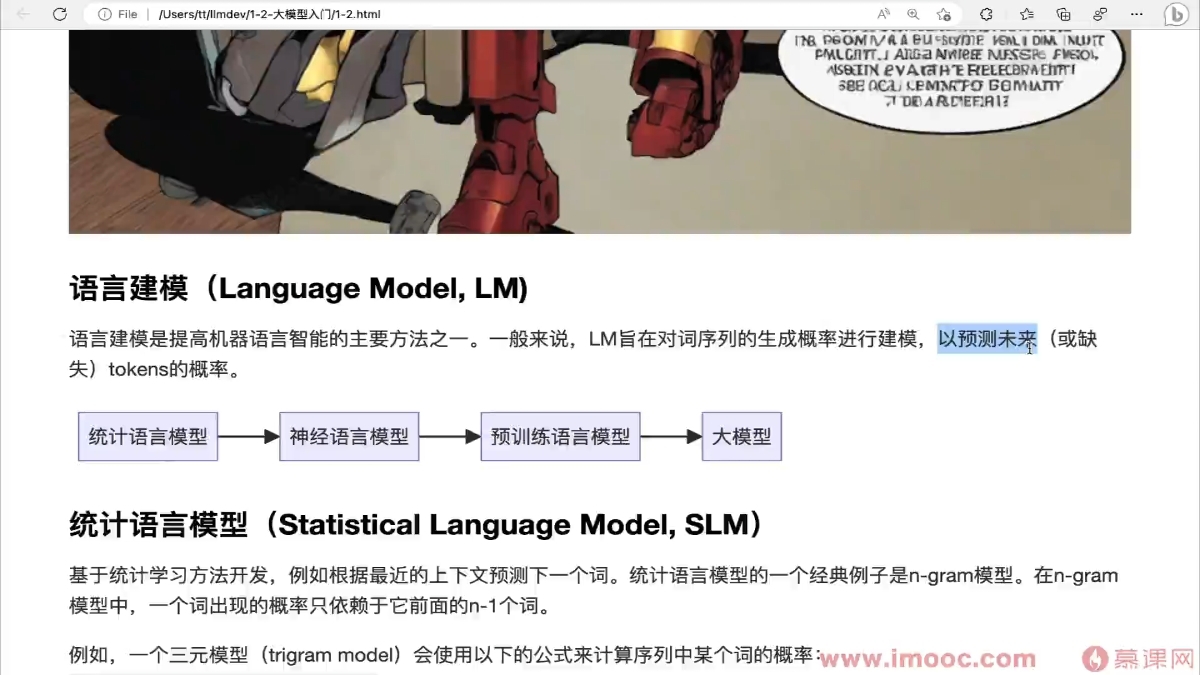

语言建模(Language Model,LM)是提高机器语言智能的主要方法之一,LM旨在对词序列的生成概率进行建模,以预测未来(或缺失)tokens的概率。

发展阶段:

统计语言模型-->神经语言模型-->预训练语言模型-->大模型

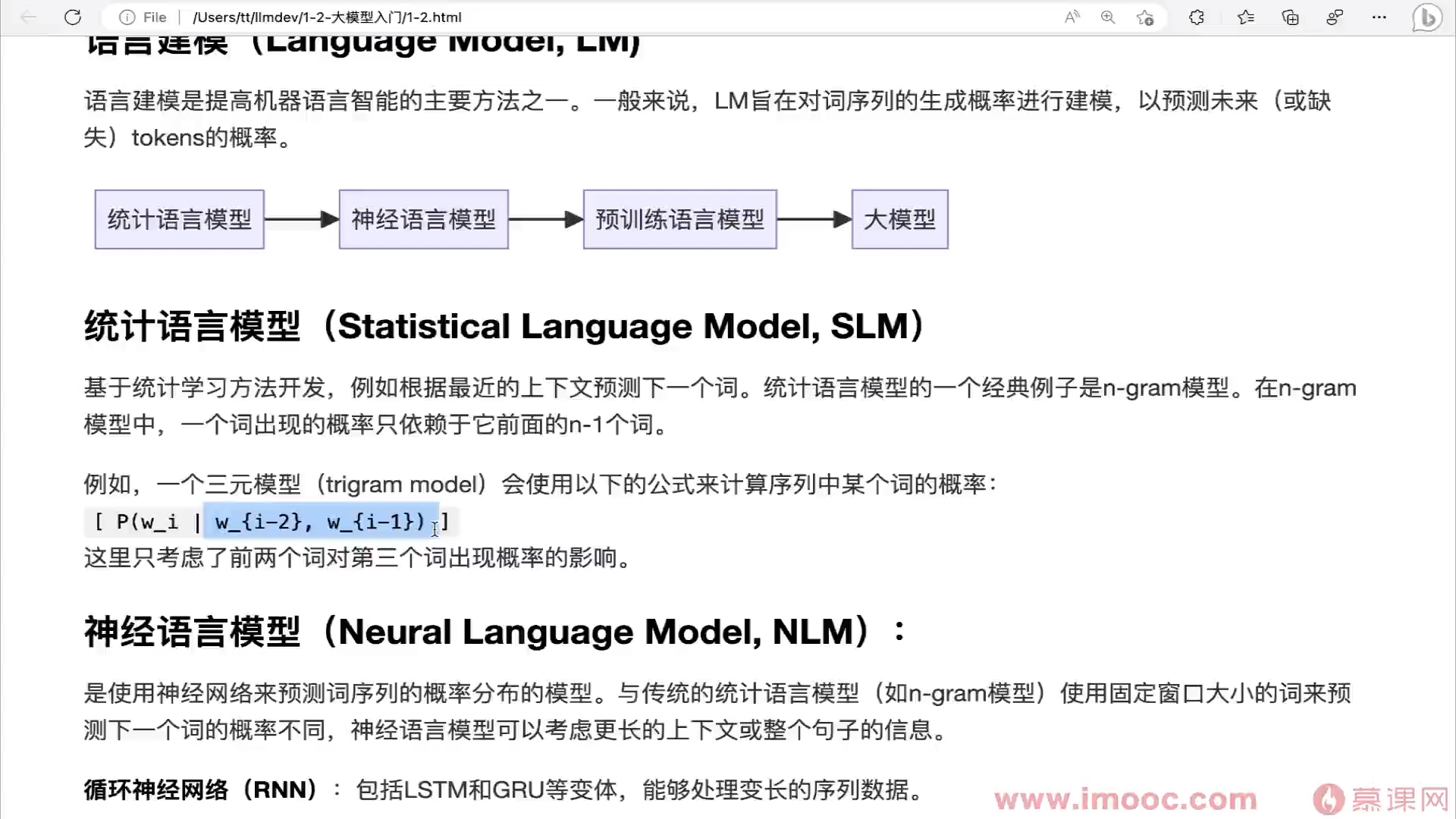

统计语言模型(Statistical Language Model,SLM)基于统计学习方法开发,例如根据最近的上下文预测下一个词。例子:n-gram模型。在n-gram模型中,一个词出现的概率只依赖于它前面的n-1个词。

特点:

使用固定窗口大小的词预测下一个词。神经语言模型(Neural Language Model,NLM)是使用神经网络来预测词序列的概率分布的模型。

特点:

可以考虑更长的上下文或整个句子的信息。循环神经网络(RUN):包括LSTM和GRU等变体,能过处理变长的序列数据。

分布式表示:在神经语言模型中,每个单词通常被编码为一个实数值向量,这些向量也被为词嵌入(word embeddingds)。词嵌入可以捕捉词与词之间的语义和语法关系。预训练语言模型(Pre-trained Language Model,PLM),这些模型通常在大规模无标签语料库上进行预训练任务,学习词汇、短语、句子甚至跨句子的语言规律和知识。通过这种预训练,模型能够捕获广泛的通用语义特征,然后可以在特定任务上进行微调(fine-tuning),以适应特定的应用场景。

Transformer

1、自注意力机制

2、并行化能力大语言模型(Large Language Models,LLM),大语言模型(大模型)是指那些具有大量参数、在大规模数据集上训练的语言模型。这些模型能够理解和生成自然语言,通常是通过深度学习和自注意力机制(如Transformer架构)实现的。它们在自然语言处理(NLP)的多个领域都有广泛的应用,包括但不限于文本生成、翻译、摘要、问答和对话系统。

预训练语言模型参数级达到了数十亿或数百亿个参数级别,称为大模型。

例如,GPT-3拥有1750亿个参数。大模型应用 BERT VS GPT

BERT(Bidirectional Encoder Representations from Transformers)和GPT(Generatice Pretrained Trans)

都是基于Transformers的架构BERT(Bidirectional Encoder Representations from Transformers)是由Google AI在2018年提出的一种预训练语言表示模型。它的主要特点是双向的Transformer编码器。这意味着BERT在处理一个单词时,会同时考虑这个单词前面和后面的上下文,这种全方位的上下文理解使得BERT在理解语言时更为精准。

BERT非常适合用于理解单个文本或者文本对的任务。比如:

1、情感分析:判断一段文本的情感倾向是正面还是负面。

2、问答系统:给定一个问题和一段包含答案的文本,BERT可以帮助找到文本中的答案。(完形填空)

3、命名实体识别(NER):从文本中识别出特定的实体,如人名、地点、组织名等。GPT(Generatice Pretrained Trans)由OpenAI提出,是一种基于Transformer的预训练语言生成模型。

与BERT不同,GPT使用的是单向的Transformer解码器。它在处理文本时主要关注当前单词之前的上下文,这使得GPT在生成连贯文本方面表现出色。

应用示例:

GPT可以应用于任何需要生成文本的场景,比如:

1、文本生成:生成新闻文章、故事、代码等。

2、机器翻译:将一种语言的文本翻译成另一种语言。

3、摘要生成:从一篇长文中生成摘要。

根据前文预测下文大模型特点

1、参数数量庞大:大模型通常含有极多的参数(10亿及以上的参数),这些参数是模型在训练过程中学习到的权重和偏置。

2、数据需求巨大:为训练这些模型,需要大量多样化的数据。数据的多样性可以帮助模型更好地泛化到未见过的情况。

3、计算资源密集:训练大模型需要大量的计算资源,这通常依赖于高性能的GPU或IPU集群。

4、泛化能力强:由于模型参数众多,大模型通常具有更好的学习能力和泛化能力。

5、迁移学习效果佳:大模型在一个任务上训练好之后,可以通过迁移学习的方式快速适应新的任务。大语言模型与AIGC之间的区别?

AIGC(Artificial Intelligence Generated Content)是一个总称,是指有能力生成内容的人工智能模型。AIGC可以生成文本、生成代码、生成图像、视频和音乐。

热门的开源AIGC技术:LLaMA 、Stable Diffusion(根据语义生成图片)

大模型也是一种AIGC,它基于文本进行训练并生成文本内容。- 0赞 · 0采集

-

- 慕九州3417969 2024-10-11

- 统计语言模型

神级网络模型

预 - 0赞 · 0采集

-

- Oralie 2024-10-11

- 0赞 · 0采集

-

- 慕粉2222252855 2024-07-09

大模型的涌现能力,这是小模型不具备的。识别双关语义和逻辑关系。

语言建模

统计语言模型——神经网络模型——预训练语言模型——大模型。

一个词的概率只依赖于前N-1个词。

神经语言模型

通过词序的概率分布的模型,可以考虑更长的上下文,神经循环网络模型。

预训练语言模型,

Transformer提出,自注意力机制和并行化,可以使用更多的资源。

长序列文本中各个词的关系。

大语言模型

理解和生产自然语言,基于Transformer。

Bert模型,可以识别情绪,可以问答系统。命名实体识别。

大模型的问题

- 1赞 · 1采集