-

- Apparition 2021-03-15

多分区原子写入

-

截图0赞 · 0采集

-

- 匪曰思存 2020-08-15

之前学rabbitmq的时候我们自己做了消息重发,也就是用了最少一次的规则。需要在消费方做幂等

-

截图0赞 · 0采集

-

- 慕瓜0579600 2020-03-07

kafka消息事务

为什么要支持事务

1)满足“读取-处理-写入”模式

2)流处理需求的不断增强

3)不准确的数据处理的容忍度

数据传输的事务定义

1)最多一次:消息不会被重复发送,最多被传输一次,但也有可能一次不传输

2)最少一次:消息不会被漏发送,最少被传输一次,但也有可能被重复传输

3)精确的一次(Exactly once):不会漏传输也不会重复传输,每个消息都被传输一次而且仅仅被传输一次,这是大家所期望的

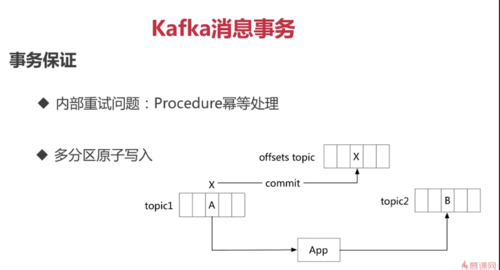

事务保证

1)内部重试问题:Procedure幂等处理

2)多分区原子写入

事务保证-避免僵尸实例

1)每个事务Producer分配一个transactional.id,在进程重新启动时能够识别相同的Producer实例

2)kafka增加了一个与transactional.id相关的epoch,存储每个transactional.id内部元数据

3)一旦epoch被触发,任何具有相同的transactional.id和更旧的epoch的Producer被视为僵尸,kafka会拒绝来自这些Procedure的后续事务性写入

- 0赞 · 1采集

-

- 小飞侠慕仔 2020-02-19

kafka消息事务

-

截图0赞 · 0采集

-

- qq_风的雨季_0 2019-11-17

- Git https://github.com/AnAngryMan/KafkaSimpleExample

-

截图0赞 · 0采集

-

- qs九点九分 2019-06-20

11111111

-

截图0赞 · 0采集

-

- 谋士张良 2019-05-11

消息事物。

-

截图0赞 · 0采集

-

- moocer9527 2019-04-20

事务保证——避免僵尸实例

-

截图2赞 · 0采集

-

- moocer9527 2019-04-20

事务保证1

-

截图0赞 · 0采集

-

- moocer9527 2019-04-20

kafka消息事务

-

截图0赞 · 0采集

-

- 萧哥 2019-03-20

Kafka避免僵尸实例

-

截图0赞 · 1采集

-

- 萧哥 2019-03-20

kafka事务保证

-

截图0赞 · 0采集

-

- 萧哥 2019-03-20

kafka数据传输的事务定义

-

截图0赞 · 1采集

-

- 萧哥 2019-03-20

Kafka为什么要支持事务

-

截图0赞 · 0采集

-

- 慕无忌4111159 2019-03-04

Kafka消息事务保证——避免僵尸实例

-

截图0赞 · 0采集

-

- 慕无忌4111159 2019-03-04

Kafka消息事务事务保证

-

截图0赞 · 0采集

-

- emotion1 2019-02-28

事务保证-避免僵尸实例

-

截图0赞 · 0采集

-

- emotion1 2019-02-28

事务保证

内部重试问题:Procedure幂等处理 比如超时 比如内部失败

Procedure是kafka 内部消息传输组件 他有send方法进行数据发送

如果发送失败的话,那么消息会重复发送。kafka自身做了幂等处理。

多分区原子写入

-

截图0赞 · 0采集

-

- emotion1 2019-02-28

数据传输的事务定义

-

截图0赞 · 0采集

-

- emotion1 2019-02-28

kafka 消息事务

-

截图0赞 · 0采集

-

- shenhengtong 2018-12-04

kafka消息事务

事务保证-避免僵尸实例

-

截图0赞 · 0采集

-

- shenhengtong 2018-12-04

kafka消息事务

-事务保证

-

截图0赞 · 0采集

-

- shenhengtong 2018-12-04

kafka消息事务

-数据传输的事务定义

-

截图0赞 · 0采集

-

- shenhengtong 2018-12-04

kafka消息事务

-为什么要支持事务?

-

截图0赞 · 0采集

-

- shenhengtong 2018-12-04

kafka高级特性

-消息事务

-

截图0赞 · 0采集

-

- lvjisheng3313895 2018-12-03

数据传输的事务定义:

- 0赞 · 0采集

-

- 霜花似雪 2018-11-15

kafka消息事务——事务保证避免僵尸实例

-

截图0赞 · 0采集

-

- 霜花似雪 2018-11-15

kafka消息事务——数据传输的事务定义

-

截图0赞 · 0采集

-

- 霜花似雪 2018-11-15

kafka消息事务

-

截图0赞 · 0采集

-

- 慕娘6452822 2018-10-19

一个消息在该偏移量被提交时,被视为【消息被消费】

- 0赞 · 0采集