LightGBM 的特征重要性

我使用多种算法训练了一个模型,包括来自skicit-learn 的随机森林和LightGBM。这些模型在准确性和其他统计数据方面表现相似。

问题在于这两种算法在特征重要性方面的行为不一致。我使用了默认参数,并且我知道它们使用不同的方法来计算特征重要性,但我认为高度相关的特征应该始终对模型的预测产生最大的影响。随机森林对我来说更有意义,因为高度相关的特征出现在顶部,而 LightGBM 则不然。

有没有办法解释这种行为,并且 LightGBM 的结果是否值得信赖?

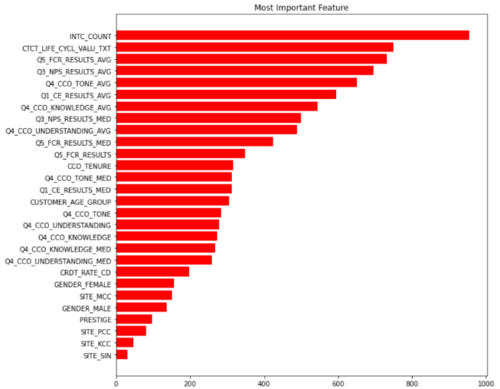

随机森林特征重要性

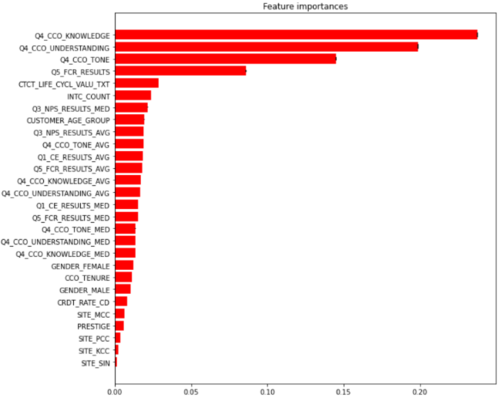

LightGBM 特征重要性

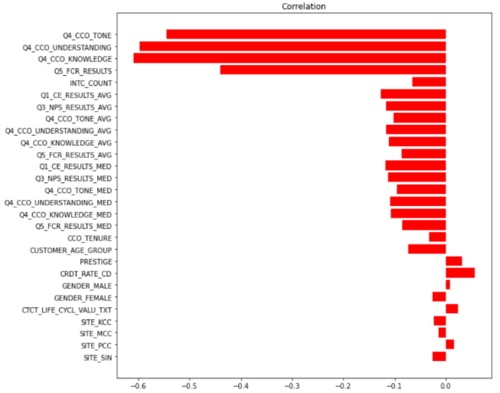

与目标的相关性

慕容708150

慕容708150浏览 467回答 2

2回答

-

蛊毒传说

我也有类似的问题。LGBM 的默认特征重要性基于“分裂”,当我将其更改为“增益”时,绘图给出了类似的结果。 -

小唯快跑啊

嗯,GBM 通常表现得更好,尤其是与随机森林进行比较时。尤其是与 LightGBM 进行比较时。与随机森林相比,经过适当调整的 LightGBM 很可能在性能和速度方面获胜。GBM的优点:More developed. A lot of new features are developed for modern GBM model (xgboost, lightgbm, catboost) which affect its performance, speed, and scalability.GBM的缺点:Number of parameters to tune Tendency to overfit easily如果您不确定 LightGBM 的超参数是否正确调整,请坚持使用随机森林;这将更容易使用和维护。

随时随地看视频慕课网APP

随时随地看视频慕课网APP

相关分类

Python

Python