Spark目录下没有lib目录,-bash: sbt/sbt: Permission denied

1、想要解决的问题:

Spark目录下没有lib目录。

2、一句话描述:

Spark目录下没有lib目录, 于是我使用“sbt/sbt assembly”命令打包,但是mac终端提示-bash: sbt/sbt: Permission denied

3、详细情况:

在用Intellij创建Scala项目时,我参考的《Spark开发环境配置及流程》提到:

“

选择菜单中的“File”→“project structure”→“Libraries”,然后点击“+”导入spark-assembly-1.2.0-hadoop2.4.0.jar。

这个jar包包含Spark的所有依赖包和Spark源码。一开始我们下载的Spark版本是预编译版本的(见《Spark on yarn搭建过程》 ),所以这个包可以在解压的Spark目录下lib目录里找到,假如说下载的没有编译的,需要通过sbt/sbt assembly命令打包。

”

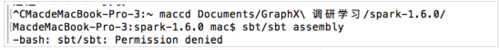

于是我在spark源代码目录spark-1.6.0运行了sbt/sbt assembly命令,如下图所示:

但是mac终端提示-bash: sbt/sbt: Permission denied

4、备注

使用的系统:最新版的mac系统

5、需要解决的关键问题:

Spark目录下没有lib目录。

PIPIONE

PIPIONE浏览 2421回答 2

2回答

-

幕布斯6054654

可能下载的源码有问题,重新下载再编译,或者下载预编译版本(里面有jar包)。还有可能是sbt本身没有安装好。

随时随地看视频慕课网APP

随时随地看视频慕课网APP

Spark

Spark