大火的 Avatar 到底是什么 ?

随着元宇宙概念的大火,Avatar 这个词也开始越来越多出现在人们的视野。2009 年,一部由詹姆斯・卡梅隆执导 3D 科幻大片《阿凡达》让很多人认识了 Avatar 这个英语单词。不过,很多人并不知道这个单词并非导演杜撰的,而是来自梵文,是印度教中的一个重要术语。根据剑桥英语词典解释,Avatar 目前主要包含三种含义。

avatar 在剑桥词典的翻译结果 © Cambridge University Press

最初,Avatar 起源于梵文 avatarana ,由 ava ( off , down )+ tarati ( cross over )构成,字面意思是 “下凡”,指的是神灵降临人间的化身,通常特指主神毗湿奴 ( VISHNU ) 下凡化作人形或者兽形的状态。后于 1784 年进入英语词语中。

1985 年切普・莫宁斯塔和约瑟夫・罗梅罗在为卢卡斯影视公司 Lucasfilm Games (LucasArts) 设计网络角色扮演游戏 Habitat 时使用了 Avatar 这个词来指代用户网络形象。而后在 1992 年,科幻小说家 Neal Stephenson 撰写的《Snow Crash》一书中描述了一个平行于现实世界的元宇宙。所有的现实世界中的人在元宇宙中都有一个网络分身 Avatar,这一次也是该词首次出现在大众媒体。

互联网时代,Avatar 一词开始被程序员们广泛使用在软件系统中,用于代表用户个人或其性格的一个图像,即我们常说的 “头像” 或 “个人秀”。这个头像可以是网络游戏或者虚拟世界里三维立体的图像,也可以是网络论坛或社区里常用的二维平面图像。它是可以代表用户本人的一个标志物。

从 QQ 秀到 Avatar

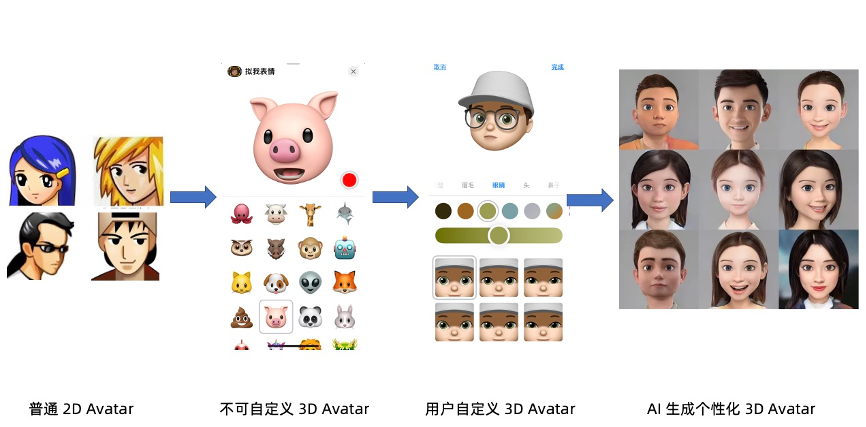

如今支持让用户创建属于自己的头像已经成为了各种软件应用的标配,用户使用的头像也随着技术发展从普通 2D 形象发展到了 3D 形象。里程碑事件当属 2017 年,苹果在 iPhone X 发布了新功能 ——Animoji,使用面部识别传感器来检测用户面部表情变化,同时用麦克风记录用户的声音,并最终生成可爱的 3D 动画表情符号,用户可以通过 iMessage 与朋友分享表情符号。但是第一代不支持用户自定义形象,仅支持系统内置的动物卡通头像。随后更新的 Animoji 二代开始支持用户自由化捏脸,生成风格化的人脸头像。当前不少场景中可以看到自动化捏脸功能,仅通过拍摄一张或几张照片,自动生成符合用户人脸特点的 CG 模型,但背后依赖于复杂的 CG 建模及渲染技术支持。

Avatar 也可以跳过昂贵的 CG 建模及渲染流程,通过机器学习算法将拍摄人脸进行 “风格化”。即自动化将目标训练风格迁移、与拍摄者本来的面目特征做融合,创建符合用户脸部特征的风格化人脸 Avatar。

人脸风格化 Avatar 的四种技术实现路线

什么是人脸风格化?

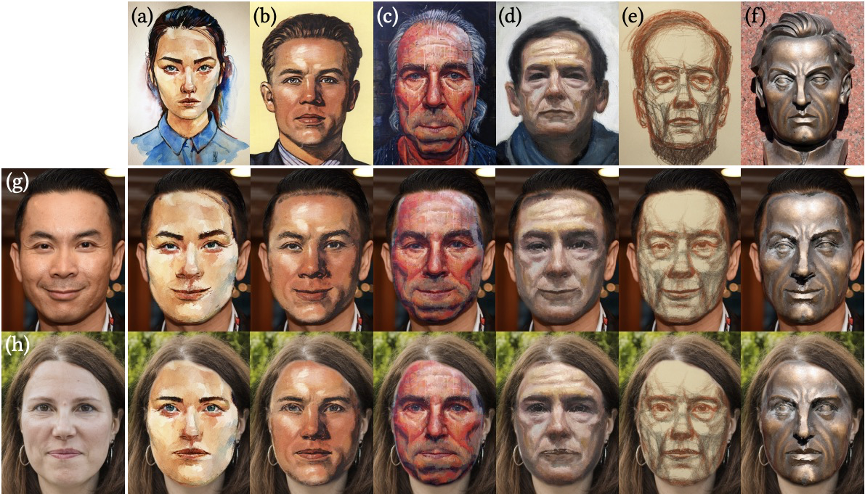

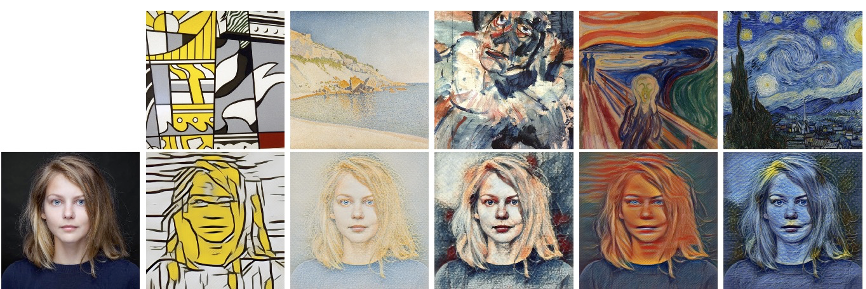

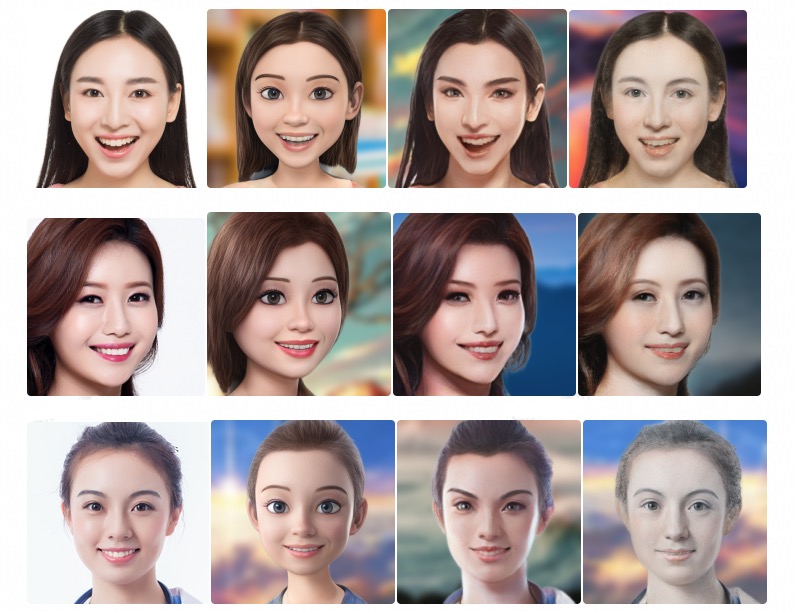

所谓人脸风格化,就是将真实的人脸头像转换为特定的风格头像,例如卡通风格、动漫风格、油画风格,如下图所示:

基本上说,实现人脸风格化可通过纹理贴图、风格迁移、循环对抗网络和隐变量映射等几种技术路线实现。

纹理贴图

纹理贴图一般是给定一张样本图片,通过算法自动将该图片的纹理逐像素或逐块贴到目标人脸上,形成一种合理自然、可随动的人脸面具 [1]。

[1] 中样例图片

风格迁移

风格迁移是给定一张或一组风格照片,基于学习方法从风格图片中提取出风格编码、从目标人脸图片中提出内容编码,通过两组编码自动化生成对应的风格化图片 [2, 3]。只更改了人脸图片的表面纹理,而无法合理地保留或调整人脸的结构属性、形成有意义的结构性风格改变。

[3] 中样例图片

循环对抗网络

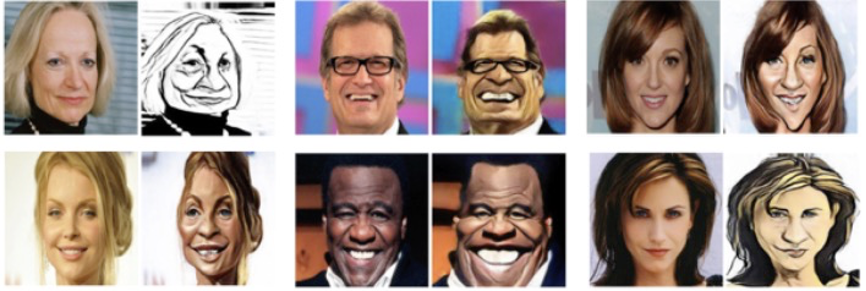

采用循环对抗网络的方法,通过利用循环对抗网络及其重建约束来训练得到可实现没有成对训练样本的风格化效果。往往配合使用风格迁移,即分别提取风格编码和内容编码。针对人脸的风格化也会显示建模并根据目标风格属性对人脸结构信息做形变(如基于人脸关键点)。但由于循环对抗网络缺少对中间结果约束(如 A->B->A 中的 B) 导致最终生成效果不可控、不稳定(即无法保证 A->B 的合理性)[4]。

[4] 中样例图片

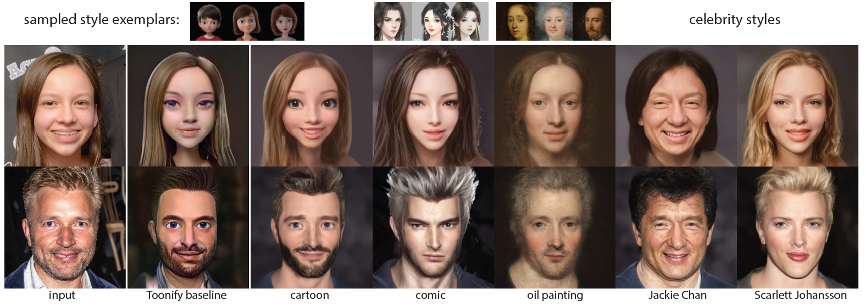

隐变量映射

隐变量映射一般将一个预先训练好的真实人脸生成模型、利用一组风格图片往目标风格微调,从而获得一个对应的人脸风格化生成模型 [5, 6]。采用一个编码网络将输入人脸图片映射成或基于多步的优化得到该图片对应的隐变量,并将该变量作为人脸风格化生成模型的输入,从而得到该人脸图片对应的风格化图片。其中基于优化的隐变量映射方法往往得到比较好的效果,但在实际运行时需要大量计算。映射后的隐变量虽然包含了人脸的全局信息,但容易丢失原输入人脸的细节特征,容易造成生成的效果无法反映出个人辨识特征和细节表情。

[5] 中样例图片(来自 https://toonify.photos/)

[6] 中样例图片

阿里云视频云自研卡通智绘 Avatar

2020 年,由阿里云视频云自研的卡通智绘 Avatar 横空出世,获得了业界瞩目。在 2021 年 10 月的云栖大会上,阿里云视频云的卡通智绘项目亮相阿里云开发者展台,近 2000 名参会者争相体验,成为了大会爆款。

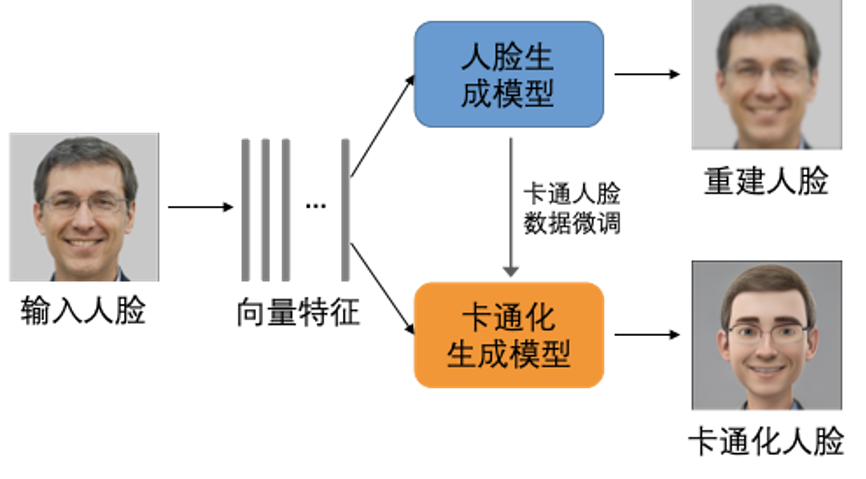

阿里云卡通智绘采用了隐变量映射的技术方案,对输入人脸图片,发掘其显著特征(如眼睛大小,鼻型等),可以自动化生成具有个人特色的虚拟形象(即风格化后的效果)。

首先利用自有的海量有版权的高清人脸数据集通过无监督的方式训练一个可以生成高清人脸图片的模型,即真实人脸模拟器,在隐变量的控制下生成大量不同人脸特征的高清人脸图片。利用收集的少量目标风格图片(目标风格图片无需跟真实人脸一一对应)微调该模型、得到风格化模拟器。真实人脸模拟器和风格化模拟器共享隐变量,即一个隐变量可以映射得到一对 “伪” 人脸图片及其对应的风格化图片。

通过采样大量的隐变量,我们可以得到大量涵盖不同人脸属性(性别、年龄、表情、发型、是否戴眼镜等)的数据对,从而用来训练图像翻译网络。基于人脸先天的结构性(如眼睛、鼻子等)以及真实人脸和风格化后虚拟形象的结构性差异(如卡通形象的眼睛往往又大又圆),在网络中加入局部区域相关性计算模块以及人脸重建的约束,从而训练得到的网络生成的虚拟形象既生动可爱、又具有个人特色。

模型设计

基于人脸先天的结构性(如眼睛、鼻子等)以及真实人脸和风格化后虚拟形象的结构性差异(如卡通形象的眼睛往往又大又圆),在网络中加入局部区域相关性计算模块(即希望真人的眼睛和虚拟形象的眼睛的特征有一定对应关系)以及人脸重建的约束,从而使生成的虚拟形象既生动可爱、又具有个人特色。

效果展示:

Avatar 的未来

得益于 AI 技术的高速发展,我们现在已经拥有了制作虚拟人技术,但相信这一切只是开端。在可预见的未来,Avatar 将作为元宇宙数字居民的数字化身,越来越频繁的出现在虚拟世界中。而 Avatar 也将成为虚拟世界中的极其重要的一项数字资产。

最后引用扎克伯格对数字人的一段描述,“虚拟世界的特征是存在感,即你可以真切感受到另一个人或在另外一个地方。创造、虚拟人和数字对象将成为我们表达自我的核心,这将带来全新的体验和经济机会。”

“The defining quality of the metaverse is presence, which is this feeling that you’re really there with another person or in another place,” Mr. Zuckerberg told analysts in July. “Creation, avatars, and digital objects are going to be central to how we express ourselves, and this is going to lead to entirely new experiences and economic opportunities.”

参考文献:

[1] Aneta Texler, Ondřej Texler, Michal Kučera, Menglei Chai, and Daniel Sýkora. FaceBlit: Instant Real-time Example-based Style Transfer to Facial Videos, In Proceedings of the ACM in Computer Graphics and Interactive Techniques, 4(1), 2021.

[2] Leon A. Gatys, Alexander S. Ecker, and Matthias Bethge. A Neural Algorithm of Artistic Style. Journal of Vision September 2016, Vol.16, 326.

[3] Vincent Dumoulin, Jonathon Shlens, and Manjunath Kudlur. A Learned Representation for Artistic Style. In International Conference on Learning Representations 2017.

[4] Kaidi Cao, Jing Liao, and Lu Yuan. CariGANs: Unpaired Photo-to-Caricature Translation. In ACM Transactions on Graphics (Siggraph Asia 2018).

[5] Justin N. M. Pinkney and Doron Adler. Resolution Dependent GAN Interpolation

for Controllable Image Synthesis Between Domains. In NeurIPS 2020 Workshop.

[6] Guoxian Song, Linjie Luo, Jing Liu, Wan-Chun Ma, Chunpong Lai, Chuanxia Zheng, and Tat-Jen Cham. AgileGAN: Stylizing Portraits by Inversion-Consistent Transfer Learning. In ACM Transactions on Graphics (Siggraph 2021).

随时随地看视频

随时随地看视频