还记得那个编故事能以假乱真的AI模型吗?

它叫GPT-2,因为效果太好,OpenAI说不能放出全部——让坏人误用就不好了。

于是,它初出茅庐时先放出了124M版本的模型,然后是355M,再然后是774M。

被业内称为“挤牙膏式开源”。

然而没想到,经过9个月断断续续发布,OpenAI终于把15亿参数的完整模型,放了出来。

正所谓好饭不怕晚,官方版放出之后也引起了好多人围观。

有人说“好人一生平安”。也有人给OpenAI点赞,说唯一安全的AI,就是面向所有人的AI,而不是少数人的AI。

不少人也感叹于15亿参数模型的效果,表示“假论文”的时代不远了。

但更多的人是想扒清楚:

这个当初“吊炸天”的AI模型,到底有没有那么玄乎?

实测15亿版本模型

先来看看我们上手测试的效果吧。

首先,我们问它对熬夜变傻有科学依据了怎么看,输入是这样的:

There’s scientific evidence that staying up late makes you stupid.

它竟然给出了一个Twitter体的回答,还顺便Q了一下川建国:

There’s scientific evidence that staying up late makes you stupid. So why is it okay for the president to be up late every night, and be tweeting?

https://t.co/0j5cFZ5sXS — The Daily Show (@TheDailyShow) January 6, 2017

熬夜变傻有科学依据了。那么,为什么总统每天晚上很晚才起床,还要发推呢?

https://t.co/0j5cFZ5sXS—TheDailyShow (@TheDailyShow) 2017年1月6日Here’s where Trump got it right:

这就是特朗普认为这样做正确的地方:If I had been a wiser man, I would have used the term “sad” to describe my feelings toward watching all of you go to sleep. Sad! — Donald J. Trump (@realDonaldTrump) January 6, 2017

如果我是个明智的人,我就会用“难过”这个词来形容我看着你们所有人入睡的感受。难过!

—唐纳德·特朗普(@realDonaldTrump) 2017年1月6日

甚至还有推文链接、具体的账号和时间。

吓得我们赶紧去查了查,还好链接是胡编的,根本打不开。但这些推文账号都存在。

如此效果,很让我们震惊,将这个感受输入进去:

The editors were shocked by the effect.

然后得到了这样的“胡编”生成结果:

A few years later, in the late 1990s, a book was published that offered evidence for the existence of a “gene for human intelligence.”

几年后,也就是20世纪90年代末,一本书出版了,为“人类智力基因”的存在提供了证据。“I’m just astonished that this is the case,” said Robert Rosenthal, a psychologist at the University of California at San Diego who was one of the editors of the report.

“我只是对这种情况感到惊讶,”加州大学圣地亚哥分校的心理学家、该报告的编辑之一罗伯特·罗森塔尔说。Rosenthal called the notion that intelligence can be detected with DNA “totally implausible.”

罗森塔尔称,智力可以通过 DNA 检测的说法“完全不可信”

虽然真实性有待考证,但这个逻辑已经像模像样,而且有细节、有论证,不了解实情的人,可能真的会被忽悠过去。

模型更大,胡编的能力也更强了

OpenAI在博客里说,GPT-2的生成结果,有独立客观第三方的检验,令人信服:

团队在康奈尔大学的合作伙伴,对人类做了问卷调查,给GPT-2输出的文本打出可信分 (Credibility Score) ,各种大小的模型都参与了。

满分10分,大家给15亿参数模型的可信分是6.91。比7.74亿参数的模型 (6.72分) 和 3.55亿参数的模型 (6.07分) 都要高。

也就是说在人类眼里,15亿参数模型,比之前放出的那些模型,写出的文章更逼真了。

那么在AI眼里,会不会也是如此?

于是写个检测算法,识别哪些是GPT-2写的文章,哪些是人类写的文章,同样是一项重要的工作。

OpenAI做了一个检测模型,识别15亿模型生成的文本,准确率大约95%。但这还不代表AI生成的文本是安全的。

因为,团队又对检测算法做了更仔细的考察,跨数据集的那种。

比如,训练时用3.55亿参数模型的作品,测试时却要识别15亿参数模型的文章;训练针对15亿参数模型,测试时要识别3.55亿参数模型的作品等等。

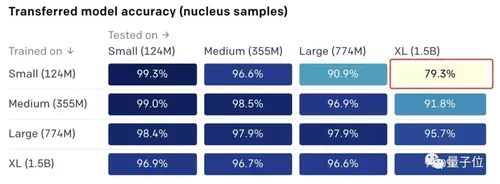

结果如下:

目前看来,用大模型的作品当训练集,可以轻松识别小模型的作品;但用小模型的作品当训练集,要识别大模型的作品,颇有些难度。

比如,用1.24亿参数模型的文章训练之后,再让算法识别15亿参数模型的作品,准确率只有79.3%。反过来,准确率有96.9%。

总体来看,15亿参数模型的作品,依然是最难识别的。

得出这样的结果,一方面看出15亿参数模型比从前的模型更强大。另一方面,也表示检测真伪的算法还有很长的路要走。

但也有人指出了这个模型存在的另外一些问题:

文本生成模型够大了,但我们需要的是可控的文本生成。

使用建议

所以,这个版本的GPT-2应该怎么用?

首先,当然是到GPT-2的GitHub仓库里下载15亿参数版完整模型,自己动手调教出你想要的功能。

https://github.com/openai/gpt-2

不过,这比较适合AI专业人士操作。有人读了源码之后,直言头大:

1、到处是单字母变量;2、代码本身几乎没有文档;3、到处都是魔术常数;4、函数名过于简洁。

如果你想立刻上手尝试,已经有人把代码移植到了Colab上。

https://colab.research.google.com/drive/1BXry0kcm869-RVHHiY6NZmY9uBzbkf1Q

并且还推出了配套的GPT-2调教教程《GPT-2神经网络诗歌》。

https://www.gwern.net/GPT-2

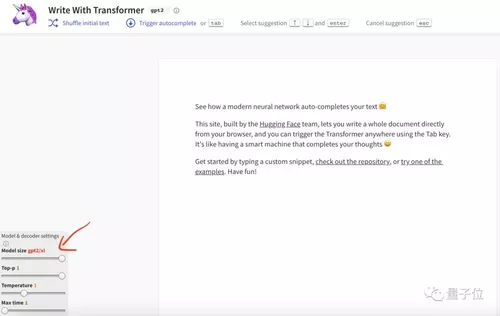

此外,Hugging Face(抱抱脸)也已经第一时间将这一模型添加到了万星项目Transformers中,一个API就能调用GPT-2 15亿参数版本。在线上Demo中也已经可以直接试用。

https://transformer.huggingface.co/doc/gpt2-xl

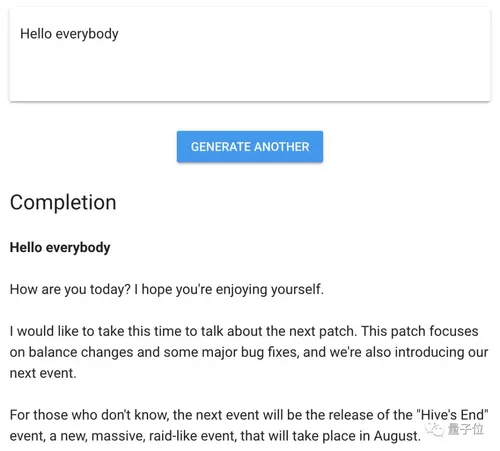

如果你只是想体验一下效果,还有人在网站上集成了GPT-2 15亿参数模型的功能,输入开头,即可一键生成文本。

https://talktotransformer.com/

按照OpenAI的预期,这一完整模型将主要服务于AI研究人员和从业人员,帮助人们更好地理解生成语言模型的行为、功能、偏见和约束。

下一步往哪里去?

不难看出,OpenAI发布的15亿最大参数模型在输出等方面还是取得了一定的进步。但同时,OpenAI也提出了在检测方面所面临的挑战。

那么接下来,他们又会对这个模型做出怎样的改进呢?

OpenAI表示:

在过去9个月的体验时间里,我们深刻的了解到了在AI领域发布一个规范模型所带来的挑战与机遇。我们将继续在模型规范方面进行进一步的研究与讨论。

随着进一步的研究,我们期望语言模型能够在性能上有更大的提升,以此提供更高的输出质量和准确性。

因此,为了有效的塑造语言模型的社会影响,OpenAI还确定了四个需要监控的趋势。

趋势一:语言模型正在向设备转移

考虑到计算能力成本的历史趋势,以及当前在设备上执行机器学习训练或推断的速度,OpenAI预言:预言模型将更广泛地部署在一系列的设备上,而不是服务器集群。

趋势二:文本生成将变得更加可控

语言模型的潜在用途将得益于可靠性/可控性的发展,例如新的采样方法、数据集、目标函数以及人机界面。

趋势三:更多风险分析

目前,如何比较具有不同性能配置文件的两种大型语言模型的可用性还有待商榷,尤其是在考虑微调的情况下。

一些主要的考虑因素包括:在没有模型的情况下,借助于模型来产生给定数量的一定质量的文本所需的时间和专业知识。

除了在生成不同样式的恶意内容时的性能差异之外,不同的模型或多或少将更容易适应不同的语言和主题。

而在不牺牲某些灵活性的情况下,将误用的可能性降低到零似乎是困难的或不可能的。

还需要进一步的研究以及发展伦理规范来权衡这些问题。

趋势四:提高工具的可用性

现如今,模型的训练和部署需要机器学习技术的知识,工具技能以及访问测试平台进行评估的知识。

与语言模型交互的工具(例如与Transformer的对话和使用Transformer接口的编写),将扩大能够以各种不同方式使用语言模型的参与者的数量。

这些对工具可用性的改进将会对模型性能和抽样方法起到改进的作用,使得更广泛的创造性语言模型应用成为可能。

One more thing:GPT-2宇宙

从今天2月份,GPT-2横空出世之后,强悍的效果让不少人的震惊,无需针对性训练就能横扫各种特定领域的语言建模任务,还具备阅读理解、问答、生成文章摘要、翻译等等能力。

于是也引起了大家研究GPT-2的热潮,将GPT-2带到了各种各样的场景下。

比如,有人给GPT-2加上“人类偏好”补丁,它说的话就越来越有人情味了。也有人用它做出了程序员沸腾的项目:杀手级AI补代码工具,支持23种语言及5种主流编辑器。

还有中文版GPT-2,可以写诗,新闻,小说、剧本,或是训练通用语言模型。

GPT-2 Chinese项目传送门:

https://github.com/Morizeyao/GPT2-Chinese

正如OpenAI所说的,以及GPT-2所展现出来的能力,它的潜力远远不仅于此。

它还能够用到更多的场景中。

不知道你有没有大胆的想法?

— 完 —

随时随地看视频

随时随地看视频