简介

RAGFlow 是一款基于深度文档理解构建的开源 RAG(Retrieval-Augmented Generation)引擎。RAGFlow 可以为各种规模的企业及个人提供一套精简的 RAG 工作流程,结合大语言模型(LLM)针对用户各类不同的复杂格式数据提供可靠的问答以及有理有据的引用。

https://github.com/infiniflow/ragflow

安装条件

CPU >= 4核

内存 >= 16G

磁盘 >= 50G

Docker >= 24.0

Docker Compose >= v2.26.1

开始安装

1.git拉取

git clone https://github.com/infiniflow/ragflow.git

如果git拉取很慢的话,可以在github上下载ZIP文件,再通过XShell传到服务器上。

2.修改docker-compose.yml文件

cd ragflow/docker

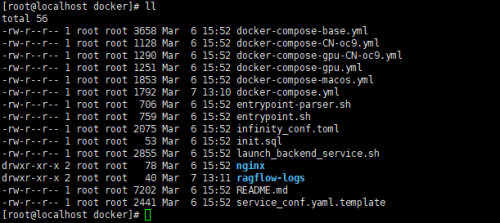

看到有如下文件:

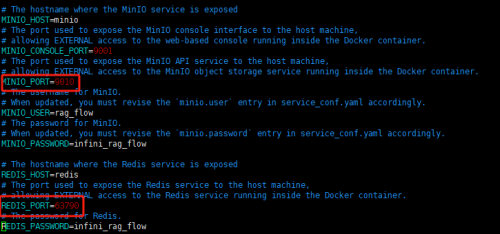

打开docker-compose.yml可以看到,ragflow需要使用80和443端口;minio需要9000端口;redis需要6379端口。因为我本地这些端口已经被其他服务占用了,所以需要重新分配端口。

如果这些端口没有被占用,可以不用修改。

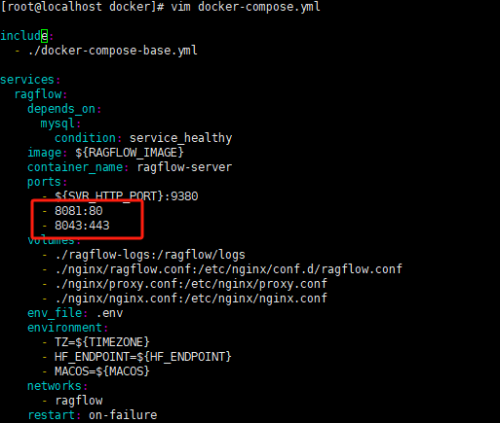

a.打开docker-compose.yml文件,将80和443端口修改成8081和8043

vim docker-compose.yml

b.打开.env文件,找到MINIO_PORT和REDIS_PORT,分别修改成9010和63790。

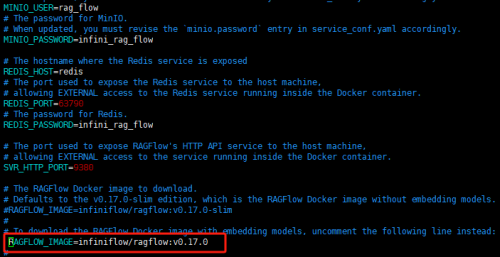

c.打开.env文件,找到RAGFLOW_IMAGE,将ragflow:v0.17.0-slim注释掉,启用ragflow:v0.17.0。内容如下。

#RAGFLOW_IMAGE=infiniflow/ragflow:v0.17.0-slim # To download the RAGFlow Docker image with embedding models, uncomment the following line instead: RAGFLOW_IMAGE=infiniflow/ragflow:v0.17.0

这样我们就能使用RAGFlow自带的embedding models了。

3.执行docker compose

docker compose -f docker-compose.yml up -d

这个过程会很慢,大约会拉取2.7G的文件。

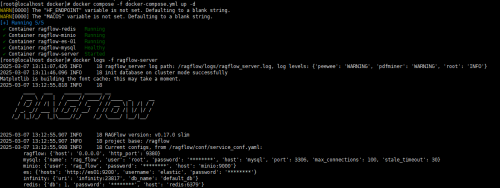

检查系统是否启动成功:

docker logs -f ragflow-server

出现上图信息时说明启动成功,这时候就可以登录系统了。

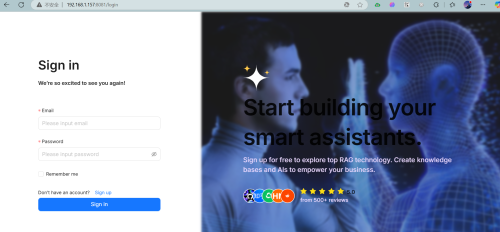

4.简单demo

为了快速上手RAGFlow,我们建一个简单的demo。

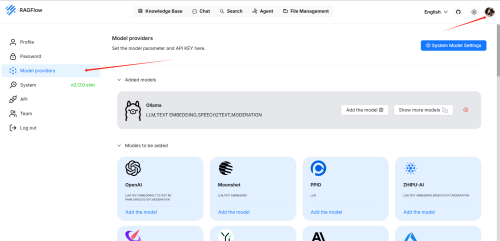

a.选择Model providers

点击头像,点击Model providers。

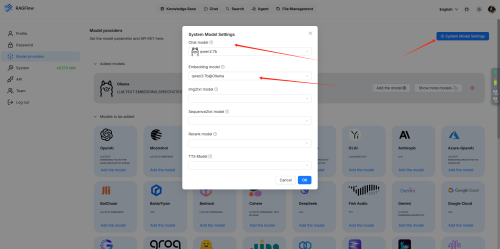

选择你需要的大模型。配置好后点击“System Model Settings”,将之前配置好的模型设为系统模型。

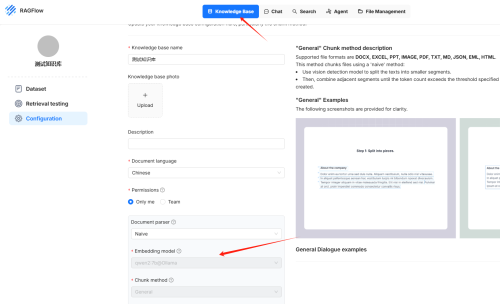

b.设置知识库

点击“Knowledge Base”,选择新建知识库。选择之前配置的嵌入模型。点击保存。

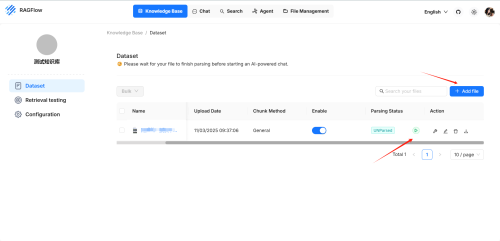

Dataset>Add file,开始解析。 这里我选了一个API文档做示例。

解析成功后可以看到分块。

c.创建聊天助手

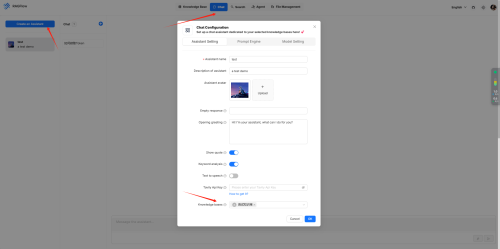

Chat>Create an Assistant。

选择刚才设置好的知识库。

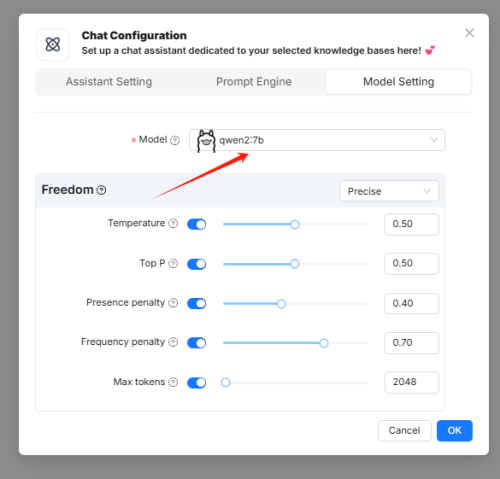

选择大模型。

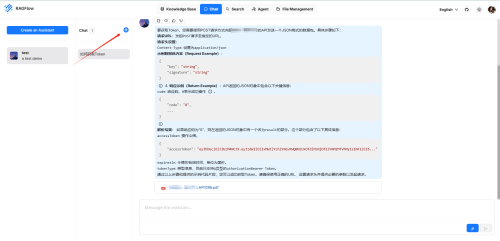

d.测试

以上配置完成后,就可以和助手聊天了。

e.最后

以上只是一个简单的demo。AI助手的效果是和选择的大模型和Rerank model相关的。前者负责回答用户的问题,后者负责解析知识库。

随时随地看视频

随时随地看视频