Windows 下 Ollama 安装deepseek本地模型

安装 Ollama

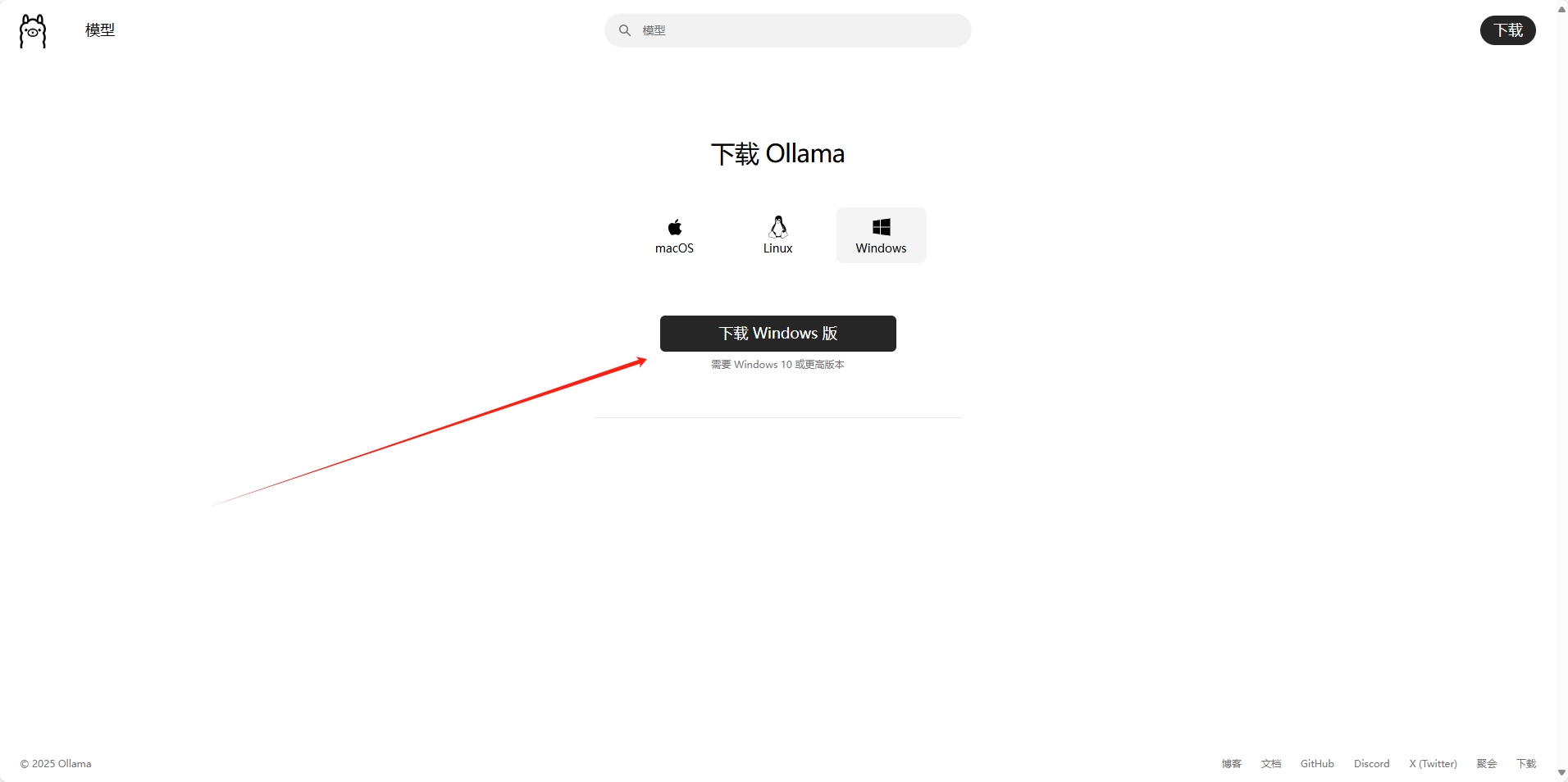

- 下载 Ollama

-

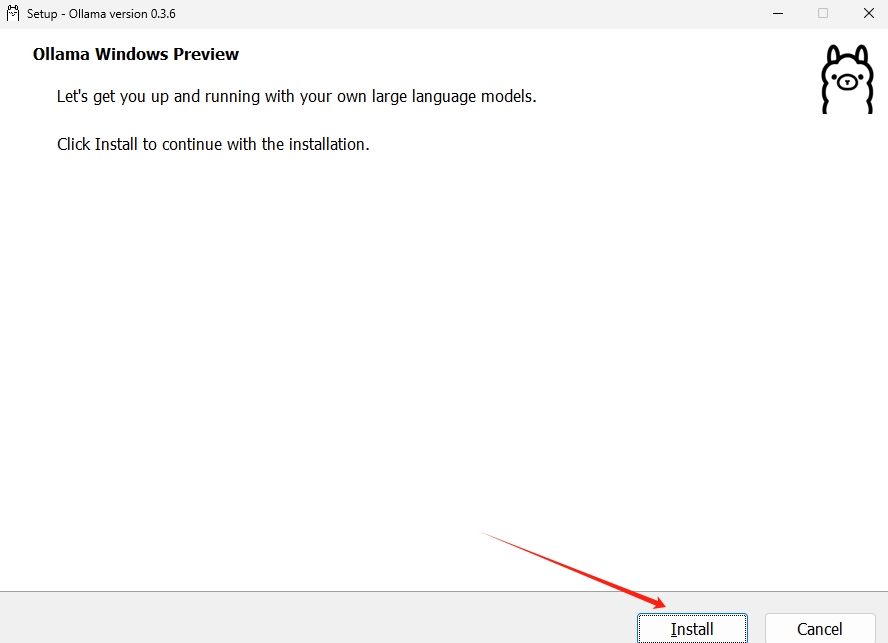

下载完成后,按照提示进行安装。

- 安装过程

-

安装完成后,安装页面会自动关闭,这是正常现象。

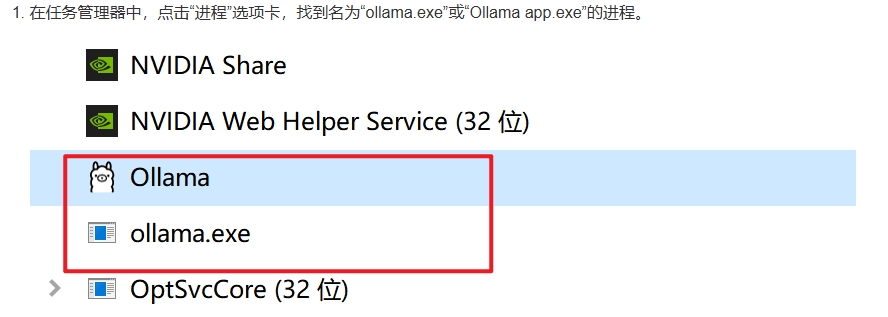

-

接下来,我们需要修改环境变量。

- 设置环境变量

- 使用以下命令在控制台中创建环境变量,修改后请记得终止相关进程:

setx OLLAMA_MODELS "D:\ollama_model"

- 常用环境变量参数

Ollama 安装完成后,建议设置以下环境变量参数以优化使用体验:

-

OLLAMA_MODELS:模型文件存放目录。默认目录为当前用户目录(Windows:

C:\Users\%username%\.ollama\models,MacOS:~/.ollama/models,Linux:/usr/share/ollama/.ollama/models)。建议 Windows 用户修改为其他目录(如:D:\OllamaModels),以避免占用 C 盘空间。 -

OLLAMA_HOST:Ollama 服务监听的网络地址。默认为

127.0.0.1,如果允许其他设备访问(如局域网中的其他电脑),建议设置为0.0.0.0。 -

OLLAMA_PORT:Ollama 服务监听的默认端口。默认为

11434,如果端口冲突,可以修改为其他端口(如:8080)。 -

OLLAMA_ORIGINS:HTTP 客户端请求来源。可以设置为

*,表示允许所有来源。 -

OLLAMA_KEEP_ALIVE:模型加载到内存后的存活时间。默认为

5m(5 分钟),可以设置为24h,表示模型在内存中保持 24 小时,以提高访问速度。 -

OLLAMA_NUM_PARALLEL:请求处理并发数量。默认为

1,可以根据实际情况调整。 -

OLLAMA_MAX_QUEUE:请求队列长度。默认为

512,超过队列长度的请求将被丢弃。 -

OLLAMA_DEBUG:输出 Debug 日志标识。开发阶段可以设置为

1,以便输出详细日志信息。 -

OLLAMA_MAX_LOADED_MODELS:最多同时加载到内存中的模型数量。默认为

1。

安装本地模型

- 安装模型

-

按下

Win + R,输入cmd打开命令提示符。 -

执行以下命令安装模型:

ollama run deepseek-r1:1.5b

- 等待安装完成后,即可开始使用模型。

- 使用模型

- 安装成功后,输入问题即可获得模型的回答。

总结

通过以上步骤,您可以在 Windows 系统上成功安装并配置 Ollama,并加载本地模型进行使用。

随时随地看视频

随时随地看视频