我为2023年春季学期在阿尔托大学选修的《表征系统》课程写了这篇文章。回顾起来,这篇文章似乎有些不成熟,但它确实包含了一些我后续项目中继续探索的想法的早期构想。在某种程度上,这篇文章为我的硕士论文《神经多样性修辞与对话AI》奠定了理论基础,这篇论文即将出版。虽然这篇文章有些过时且不够完善,且我不再完全认同其中的观点,但我认为它可能会让某些人感兴趣。请注意,这篇文章是在课程展览之前写的,因此图片中的作品展示方式与文本描述略有差异。

简介

因为这个装置有两台显示器,它们朝向相反的方向,所以需要两个人来操作:一个人输入信息,另一个人读取结果。为了防止一个人通过跳到另一侧来单独操作,一个折叠屏从两侧将作品围了起来。关于这个装置的设计和实现,可以说有很多不足之处。

几年前,聊天机器人仅仅主要用于自动化简单的客户服务任务,比如预约,。现在,随着生成式人工智能的发展,聊天机器人变得更灵活和通用;当收到提示时,ChatGPT会尝试回答几乎任何问题或生成几乎任何类型的文本内容。

虽然这些对话系统并不会假装成人类,但它们模仿了我们认为人类是如何交流的。它们所谓的沟通技巧经常被描述为类似人类的(Locke, 2022, Browne, 2023),但这到底意味着什么呢?由于ChatGPT是由肯尼亚工人训练的(Perrigo, 2023),这表明一些社交互动的规则并不是完全来源于训练数据,而是需要通过人工劳动来有意添加进去。“类似人类”的特征需要按照系统创建者们的意愿添加。

聊天机器人可以被视为对话的模拟。模拟是指“通过另一个系统的运作来模仿另一个系统或过程的运作方式”(Merriam-Webster,n.d.)。模拟受到技术和预算的限制,因此,制作者需要决定优先模拟哪些内容。正如Frasca(2003)所述:“我们知道,区分屏幕上展示的内容和被省略的内容是至关重要的。在模拟领域情况更为复杂:它不仅涉及哪些规则被包含在模型中,还涉及如何实施这些规则。”

什么是故意的行为?神经多样性研究中的一个重要主题是对意图解读狭隘性的批判(Yergeau, 2013)。正如Yergeau(2017)指出的那样,“意图不仅包括推理的过程,还包括通过沟通或表达这种推理的物理动作”。

传统上,智力被定义为在变化环境中适应的能力(斯皮尔曼,1927)。并非所有智能行为都需要传达意图。像ChatGPT这样的系统可以模拟传统上被视为智能的行为,并且通过管理和训练,它们在交流时显得更加具有意图的一致性表现。

虽然ChatGPT不能自己开始对话,并且按照指令行事,但它可以例如拒绝讨论某些话题。这是通过一个“人在环路”系统实现的,其中工作人员会对多个回答进行评价,引导系统生成更受欢迎的回答。这样做是为了避免有害的应用场景,而不仅仅是让它更像人(Schulman等,2022)。

ChatGPT 内置的调节机制体现在它类似雅努斯双面神的两种对话模式中:一方面,它可以显得非常自信和权威,几乎像一位先知一样。另一方面,它会为提供错误信息道歉,并表示其知识仅限于训练数据。

把角色想象成由各种元素拼凑起来的个体输入:“你好吗?”

ChatGPT的回答:“作为一个语言模型,我没有人类的情感,但运行正常,随时准备帮助你回答任何问题或完成任何任务。谢谢你的关心!今天我能帮您做什么呢?”

Morkkelibot的回答——:“Morkkeli主题第八变奏:非常急板,极重且充满感情。悲伤地,但不过分活泼。”

Morkkelibot的引用是意大利语,没有上下文看起来会像无意义的话。如果你继续追问,最后你就会发现这个聊天机器人会弹钢琴。他用音乐术语来形容他的情绪,就像乐曲中的主题变化。

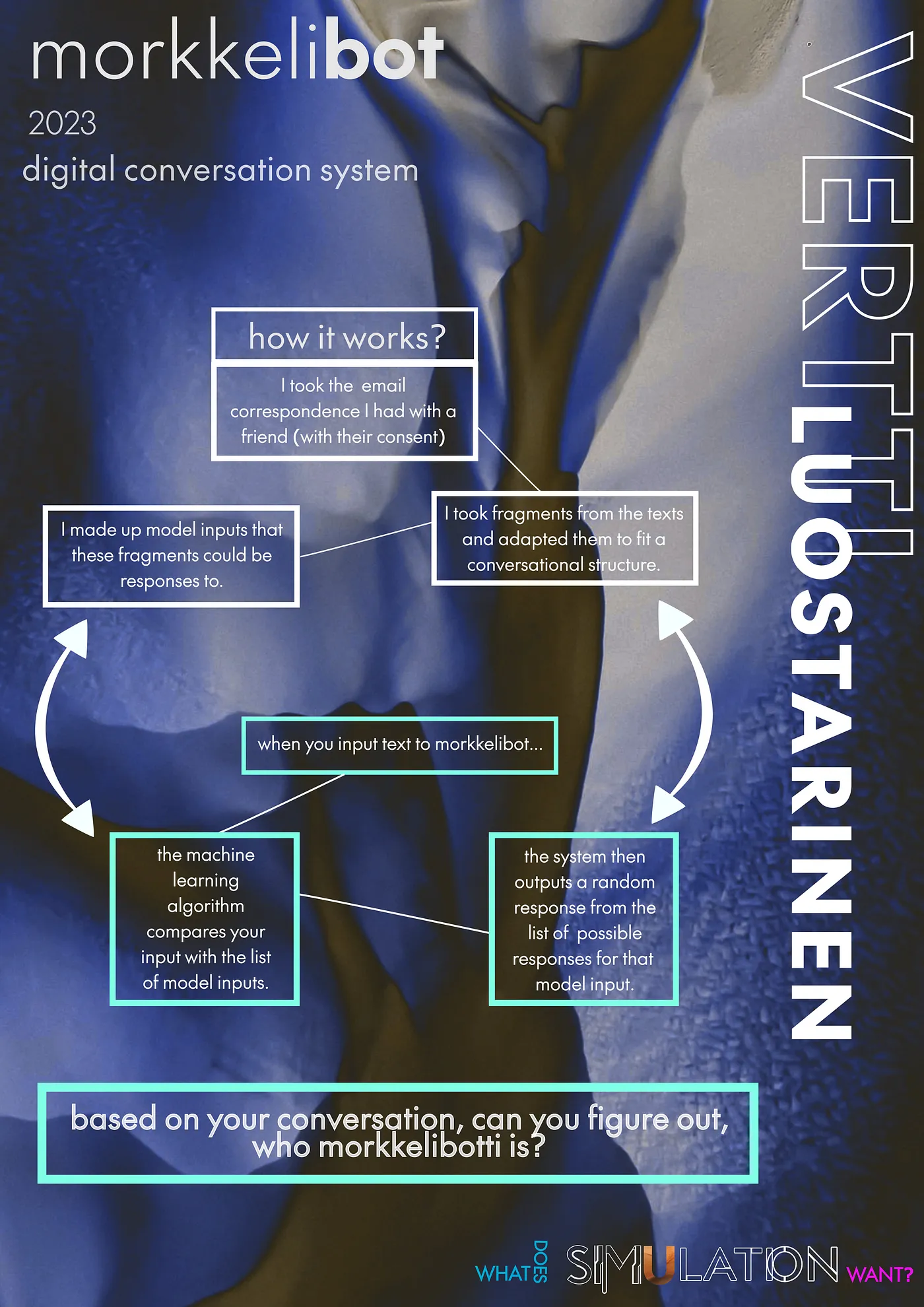

Konsta Klemetti为课程设计的海报,主题是“模拟到底想要什么呢?”

在“Morkkelibot”项目中,我将我最好的朋友在初中时期(13岁至16岁)“复活为”一个聊天机器人。在他的同意下,我仔细阅读了我们那段时间交换的数百封电子邮件,并编辑并改进了这些文本,使其更适合对话的风格。与ChatGPT不同,Morkkelibot不是生成式模型,它会一字不差地重复预设的答案。

编辑过程还涉及到为每个聊天机器人可能给出的答案创建模型问题。机器学习系统尝试在用户输入与模型问题之间找到最接近的匹配,然后根据匹配结果选择正确的答案。把朋友的邮件放到新情境中的过程带有创作性质,因为我必须想象出可能引发他反应的问题。尽管我尽量减少对朋友文本的改动,但若不进行一些叙述性写作,就无法将它们转移到模拟情境中。这个过程有点像创造一个虚构的角色。

在《千高原》中,德勒兹和瓜塔里(1987)提出了他们关于“聚合体”中形成我们所说的话的想法。“没有单独的话,只有生成话语的机器聚合体。我们说这种聚合体本质上是欲望和无意识的。它就是无意识本身。”他们继续指出,这些话真是怪诞,像是疯子说的,因为沟通总是表现出无意识。根据德勒兹和瓜塔里,人类的心理并没有那么深奥,也没有明确的意识和潜意识的区分。

这种想法也可以被看作是对意图性的批评,即个人行为背后表达的意图。他们认为,个人的行为表达的是他们的动机,而不是驱动他们行动的东西。实际上,我们的个性正是通过这个过程展现出来的:“当我们认为自己是以自己的名义说话时,实际上我们是在重复它的说法;换句话说,当我们以自己的名义说话时,我们实际上是在重复它的说法”。

在叙事理论中,角色的意图传统上与他们的行动相分离(亚里士多德,约公元前350年/1922年修订)。我有编剧的背景,在编剧领域中,角色的动机通常被分为有意识的“想要”和潜意识的“需要”(Cattrysse, 2010)。在构建Morkkelibot时,我发现德勒兹和瓜塔里的观点相当解放思维,因为我不必在文本之下强行附加一层动机,文本可以自行表达。这让我在设计模型问题时,更多地关注答案的内容,而不是想象角色的情感状态。

脱离上下文看,Morkkelibot的单独陈述似乎像是疯子的话,但结合起来则描绘了我朋友在撰写那些邮件时当时情境的整体情况。这种叙事方式似乎强调了角色所涉及的各种政治和文化体系,并把他们看作是这些体系的传递者,而非独立自主的个体。这让我决定从其他来源获取机器人的文本素材。在某些时候,Morkkelibot也会引用莎士比亚,就像我的朋友有时也会做的那样。

Morkkelibot 在更具体的层面上也类似于一个“生成声明的机械集合体”。它只有一个层次,即它的回复,并没有任何隐藏的潜意识。由于技术限制,它被固定在某个时间点上。它无法作为角色发展,因为它无法拥有欲望和需求。作品中的叙事元素通过与机器人互动和了解更多信息而浮现,而不是通过观察聊天机器人如何变化。

模拟各种交流

现在看来,Morkkelibot的用户界面无意间与Windows蓝屏界面相似,而且文字难以阅读。

输入的:“你好。”

ChatGPT的回答:“你好!今天我能帮你做什么吗?”

Morkkelibot的回答:“Kugelschnörkel”(原文如此)

创作过程让我能够以前所未有的方式挑战传统对话系统对意图的理解,特别是关于神经正常化的概念。ChatGPT被优化为最小化误差,每次给出的答案都不同且平凡,而Morkkelibot的回答总是相同的,但这些回答背后都有着一致的个性。虽然ChatGPT的答案更适应情境,表现出智慧,但没有Morkkelibot那样传达出意图性。人类并不总是追求相关性;我们可能会避开话题,偏题,甚至撒谎。

Morkkelibot 令人沮丧且混乱,甚至有时故意显得无意为之。观众可以选择将其视为一种有趣的谜题来探索,或者视为一种回避甚至敌对态度。观众可以根据自己的选择尝试猜测 Morkkelibot 的意图,如果他们愿意的话。

当然,需要考虑到的是Morkkelibot被设计成一件艺术品,而ChatGPT则是一款商用软件。有人可以认为,ChatGPT的局限性与任何从事客户服务的人员所面临的是一样的;它总是必须回答客户的问题,并根据他们提供的信息进行调整。我们通常不会质疑客户服务人员的意图或行为。

正如我们在开头讨论的,仅仅查看模拟的内容是不够的。在批评一个模拟时,我们需要审视系统整体,这意味着要关注系统认为什么是沟通。典型的神经型话语体系将非语言形式的交流视为非修辞的(Yergeau, 2015)。虽然我的材料仅限于电子邮件,但它仍然给了我一个机会,以一种通常被视为无修辞甚至非沟通的方式来使用语言。

ChatGPT把语言当作传递信息的工具,并更注重实用性而非形式感。而Morkkelibot有时更注重词语的感觉,使文本带有诗歌般的韵味(McCaffery, 1978)。 “Kugelschnörkel”本身没有意义,但它能让人感受到一种氛围,特别是当你大声说出来时。与Morkkelibot的交流可以是纯粹的感觉上的交流体验,并不局限于传统意义上的信息交流。

作为一个旁注,我认为声音诗也更符合语言模型对语言的看法:在它们看来,语言更像是一种自我参照的结构,而不是用来描述世界的工具。虽然大型语言模型表现出一些涌现特性(Wei & Tay, 2022),它们仍然处于鲍德里亚(1994)分类体系中的第三层级:“它们掩盖了深层次现实的缺失。”换句话说,它们与现实并无实际关联,尽管它们看似有所联系。

观者眼中的意图表现有时,意义的表现形式可能比意义本身更重要。正如Trento(2021)所说,当“没有明确的目标或意图在语言或身体语言中难以被神经典型者解读时,人们会假设它缺乏意义。”这一点在我观察人们与当前形式的Morkkelibot互动时变得很明显,它只是屏幕上的一段文字,没有提供任何背景信息。人们常常认为它回答得毫无关联,尽管我尽量保留了朋友给出这些答案时的上下文或背景。在我看来,如果你不假设对方有目的性,你就不会发现对方的目的性。我认为,如果我们的思想被具体化为物体,我们任何一个人都不会表现得更好。

我一直在考虑创建一个版本的机器人,让两个人面对面坐在屏幕前。一个人能看到输入,另一个人能看到输出。为了让他们与Morkkelibot互动,其中一人需要大声朗读机器人输出的文字。这样做会改变观众对Morkkelibot的心理模拟(Johnson-Laird & Oatley, 2022)的看法吗?仅仅是传达这些话语,他们对背后意图的理解会有所不同吗?他们听到这些声音诗歌时,是否会感觉更有意义?

总结

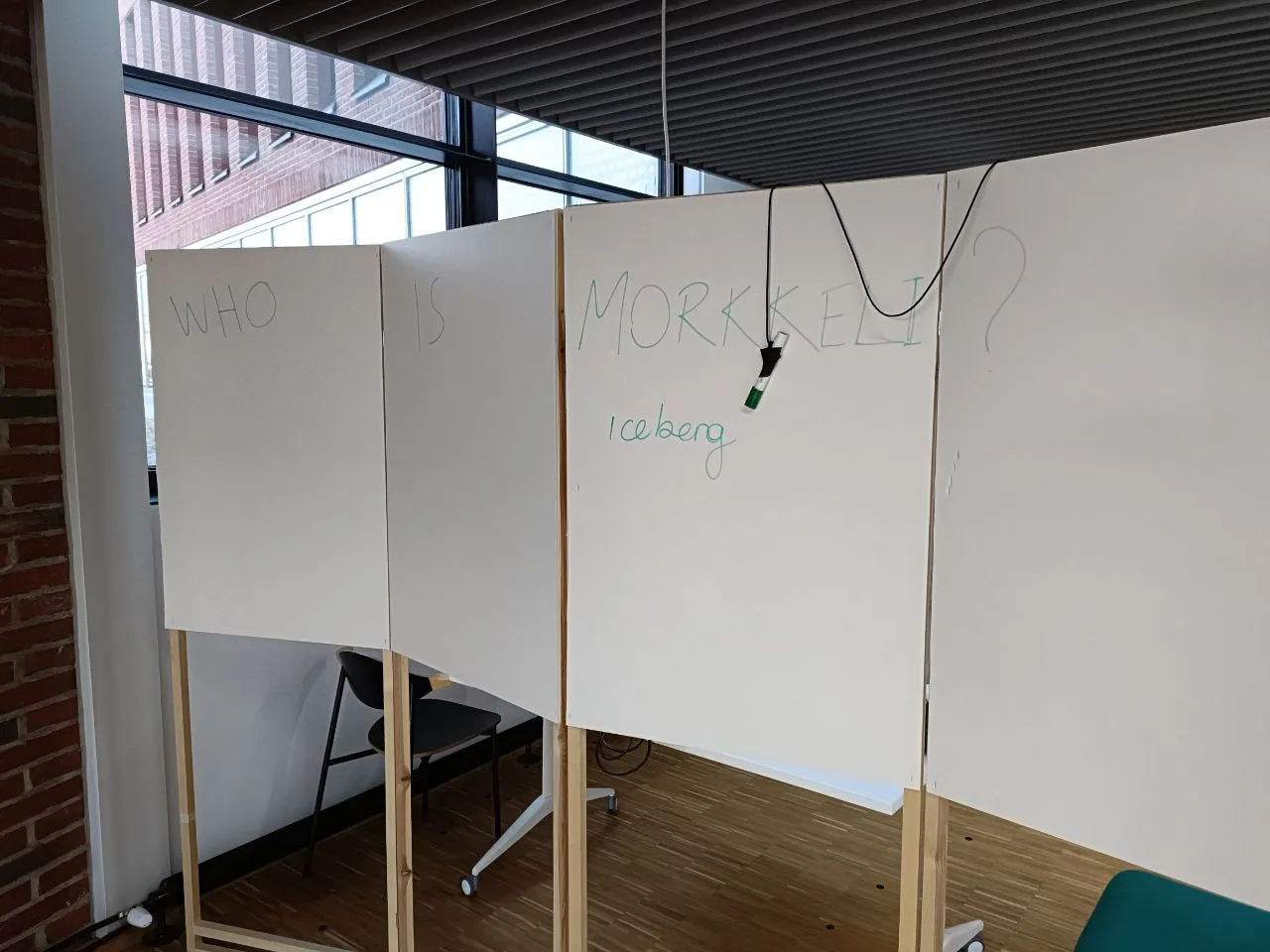

访客们可以在屏风的另一边写下他们对莫尔克利博蒂的看法。最终,只有一个人写了“冰山”。我不确定有多少人注意到屏风的另一边有文字。

GPT模型可以通过图灵测试(James, 2023)和司法考试(Katz等,2023),以及其他之前被认为只有人类才能完成的事情。我们是否应该更多地将其视为一种迹象,表明我们传统上用来衡量人类行为的方式从一开始可能就是错误的?当我们制造出能够冒充人类的机器时,同时也将那些不符合我们标准的人类排除在外。正如Yergeau(2015)所指出的,当今的医学模式将残疾人的修辞行为视为病态,而不是文化现象。

人工智能的发展推动产生了许多关于智能,甚至是所谓的“人工通用智能”可能是什么样的数学模型,但似乎没有人真正构想过一个充满多种不同智能的未来会是什么样子。正如鲍德里亚(1994)所说,模拟先于现实本身。我们在虚拟世界中所选择的建模内容会决定我们的未来。更重要的是,我们已经在虚拟世界中模拟的有意图的行为模式,在现实中也被视为理所当然的行为模式。

鸣谢:感谢莉莉·迪亚兹-科蒙内、克薇塔·米尔贾克和马克斯·瑞纳宁这三位来自阿尔托大学的朋友对本文的反馈和支持,以及《表征系统》课程的同学和贝古姆·切利克在帮助组织展览上的支持。

参考资料布朗,R. (2023, 2月8日). 关于ChatGPT,你需要知道的一切,这款让世界议论纷纷、让科技巨头之间产生竞争的人工智能聊天机器人. CNBC. https://www.cnbc.com/2023/02/08/what-is-chatgpt-viral-ai-chatbot-at-heart-of-microsoft-google-fight.html

Locke, S. (2022年12月5日). 什么是火爆的AI聊天机器人ChatGPT,它会取代人类吗?《卫报》。https://www.theguardian.com/technology/2022/dec/05/what-is-ai-chatbot-phenomenon-chatgpt-and-could-it-replace-humans

Perrigo, P. (2023, 1月18日) 独家报道:OpenAI 使用每小时不到2美元的肯尼亚工人来优化ChatGPT的内容。《时代》杂志。https://time.com/6247678/openai-chatgpt-kenya-workers/

Merriam-Webster. (未指定日期). Simulation. 在2023年4月7日从Merriam-Webster.com字典中检索。

Frasca, G. (2003). 模拟 vs 叙事:. 载于 Wolf, Mark J. P. 和 Perron, Bernard (编). 电子游戏理论读本 (第 221–235 页). 纽约:Routledge.

Yergeau, R. M. (2013). 临床显著困扰: 论理论心灵的理论家. 残疾研究季刊. 第33卷,第4期。

Yergeau. R. M. (2015) 《自闭症之声:修辞、被迫性与自闭人生的含义》。收录于 Block, P., Kasnitz, D., Nishida, A., & Pollard, N. (Eds.). (2015). 《残疾研究的占领:社区、正义与解殖化的批判视角》。Springer 荷兰。

「自闭症的修辞表达:论修辞与神经多样性酷儿」

《双峰:回归》中的后语言主体探究. WiderScreen 24 (1–2).

斯皮尔曼 (C.) (1927). 人的能力. 麦克米伦出版社.

Sculman, J. 等.(2022年11月30日发布). 发布ChatGPT. OpenAI 博客文章. https://openai.com/blog/chatgpt#OpenAI

德勒兹,G. & 瓜塔里,F. (1987). 千高原:资本主义与精神分裂. (明尼苏达大学出版社)

亚里士多德(1922年)《诗艺》,S. H. 伯特切编,麦克米伦公司出版。(原作约成书于公元前355年)

Cattrysse, P. (2010). 主角的目标、欲望和需求 (第83至97页). 电影剧本杂志 1.

MacCafferfy, S. (1978). 声音诗歌——综述. 参见 S. McCaffery & bpNichol 编著的《音诗目录》, Underwich 出版社,多伦多(Toronto)。

魏,J. & 泰,Y. (2022年11月10日,) 大型语言模型中的涌现现象研究。谷歌研究博客https://ai.googleblog.com/2022/11/characterizing-emergent-phenomena-in.html

Baudrillard J. & 格拉瑟 S. F. (1994). 拟象与模拟. 密歇根大学出版社.

约翰逊-莱尔德,P. N.,奥特莱,K. 诗歌如何激发情感。发表在《Acta Psychologica》第224期上。

詹姆斯·A. (2023年3月29日). ChatGPT通过了图灵测试,如果你感到恐慌,你并不孤单。TechRadar, 而且如果你也有同感,那就对了,你并不孤单。https://www.techradar.com/opinion/chatgpt-has-passed-the-turing-test-and-if-youre-freaked-out-youre-not-alone

Katz, D., 等 (2023). GPT-4 通过了司法考试。SSRN. https://papers.ssrn.com/sol3/papers.cfm?abstract_id=4389233

我在2023年春季学期修读的阿尔托大学《表征系统》课程中写了这篇文章。回头看,这篇文章感觉有点草率,但它确实包含了一些我后来在其他项目中继续发展的初步想法。从某种程度上说,这篇文章为我即将出版的硕士论文《神经多样修辞中的对话式AI》打下了理论基础。虽然这篇文章有些过时,尚未完成,而且我也不完全认同其中的所有观点,但我认为它可能对某些人来说仍然有参考意义。

随时随地看视频

随时随地看视频