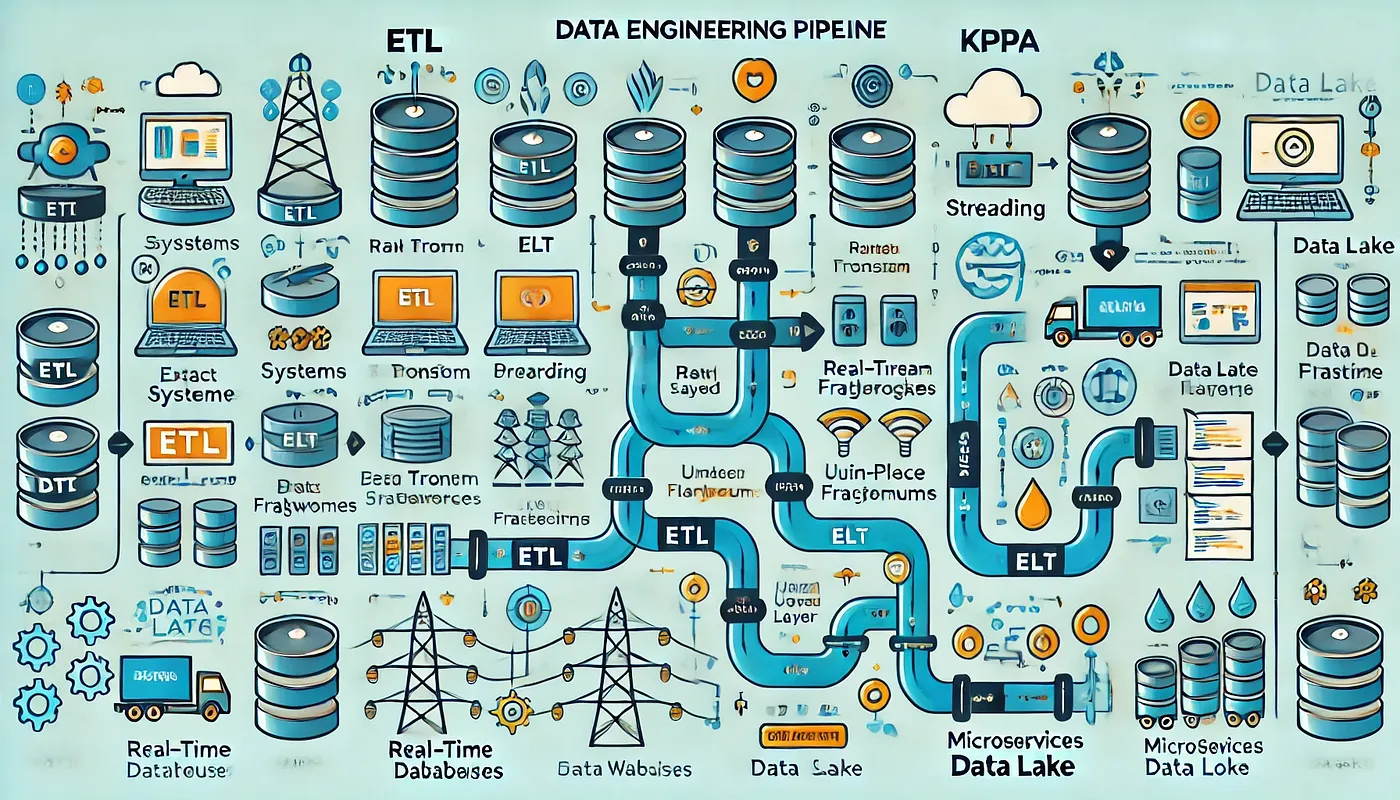

你的数据管道的效率和效果可以决定你的分析和决策能力是否成功。本文直接探讨数据工程管道的核心设计模式,侧重于每种方法的高层次描述及其优势和劣势。受Chris Garzon在其关于数据管道设计模式的见解深刻的Medium文章启发,本文提供了一份简洁明了的指南,帮助理解和实施数据工程的最佳实践,并附带一些ASCII艺术图。

数据管道设计模式简介数据管道在从一个平台到另一个平台提取、转换和加载数据方面至关重要。每种设计模式都有其独特的优缺点,根据您的具体需求和资源选择合适的设计模式非常重要。接下来,我们将探讨以下几种模式:

- ETL(提取、转换、加载)

- ELT(提取、加载、转换)

- 实时数据流管道

- Lambda架构

- Kappa架构

- 数据湖架构

- 基于微服务的数据流管道

每个模式都将被分析和评估其高层次结构、优点和可能的缺点,帮助你为数据工程项目做决策提供支持。

1 ETL (提取、转换、加载) 工作流ETL 数据管道涉及从各种来源提取数据,并通过清洗和丰富过程对其进行转换,然后将其加载到目标数据存储。此方法对于复杂的转换和结构化数据非常理想,但可能会引入延迟,并且需要大量的资源。

详细说明:

1. 提取如下所示:

- 连接源系统: 建立与各种源系统(如关系型数据库(例如 MySQL、PostgreSQL)、API(例如 RESTful 接口)和文件系统(例如 CSV、JSON))的连接。

- 数据提取: 使用连接器或 API 来提取数据。这包括编写查询来从数据库中获取数据,或者通过 API 发送 HTTP 请求。

- 调度: 经常通过工具(如 Apache Nifi、Talend 或自定义脚本)定时批量处理(例如每天或每小时)。

2. 转换:

- 数据清洗: 删除重复项,处理缺失值,纠正错误,并标准化格式。

- 数据增强: 从其他来源添加数据以增强数据集。

- 数据转换: 应用业务逻辑,聚合数据,进行计算,并将数据转换为目标模式。此步骤可能包括复杂的操作,如合并表、过滤记录和应用机器学习模型。

- 工具: 可以使用 Apache Spark、Informatica 或 Python 编写的自定义 ETL 脚本完成此步骤。

步骤三:加载:

- 目标数据存储位置: 将转换后的数据加载到数据仓库中(例如,Amazon Redshift、Google BigQuery、Snowflake)。

- 数据加载: 使用批量插入操作或数据仓库提供的优化的加载工具高效地加载数据。

- 验证: 在数据加载完成后进行数据验证,以确保数据的完整性和正确性。

好处如下:

- 数据质量: 由于进行了大量的转换处理,数据质量和一致性非常高。

- 复杂转换: 适合需要大量计算和处理的复杂转换。

- 结构化数据: 与结构化数据和清晰定义的模式配合得很好。

不足:

- 延迟: 由于批处理导致的延迟较大,不适合实时数据需求的应用场景。

- 资源密集: 对大型数据集需要大量的处理能力和时间。

- 维护: 维护起来可能比较复杂,特别是在业务逻辑经常变化的情况下。

示意图:

+------------+ +------------+ +------------+

| 源系统 | | 转换 (ETL) | | 目标系统 |

| | ----> | | ----> | |

+------------+ +------------+ +------------+

^ ^

| |

+----------------------------------------------+

抽取 导入ELT数据管道提取数据并立即加载到数据存储中,并在其中就地进行数据转换。这种方法不仅能提供灵活性,还能支持可扩展性,但面对复杂的转换时可能会显得力不从心,同时需要较多的初始加载资源。

详细说明:

1. 提取内容:

- 连接源系统: 建立与各种源系统的连接。

- 数据提取: 使用连接器或API提取数据。这通常涉及获取大量未经过重大转换的原始数据。

- 调度: 按照预定的时间间隔或实时进行数据提取。

2. 加载:

- 数据加载: 一旦数据被提取,立即加载到目标数据存储(数据湖或数据仓库)中。工具如 Fivetran 和 Stitch 可以自动化此过程。

- 存储: 将数据存储为高效查询和转换的格式。例如,Amazon S3 或 Azure Data Lake Storage 通常用于存储数据以原始格式。

3. 变换:

- 原地转换: 直接在数据仓库中使用 SQL 或数据处理框架(例如 DBT,即数据构建工具)进行数据转换。

- 优化: 利用数据仓库的计算能力高效地执行转换。这可以包括创建物化视图、分区数据和使用并行处理。

- 验证: 确保转换后的数据符合业务需求,并准备好进行分析。

福利:

- 灵活性: 更大的灵活性,使我们可以根据业务需求的变化重新处理和转换数据。

- 可扩展性: 利用了现代数据仓库的可扩展性,能够更轻松地适应业务增长。

- 成本效益: 可以更加节省成本,因为它减少了对复杂转换基础设施的需求。

不足:

- 复杂转换: 不太适合极其复杂的转换。

- 初始加载: 初次加载到数据仓库时,可能会消耗大量资源。

- 存储原始数据: 存储原始数据会占用很大的存储空间。

示意图:

+------------+ +------------+ +------------+

| 源系统(Source)| ----> | 加载 | ----> | SQL 转换 |

| | | | | |

+------------+ +------------+ +------------+

^ ^

| |

+----------------------------------------------+

抽取 转换流处理管道通过使用诸如Apache Kafka和Apache Flink这样的框架实现实时数据摄取和处理。这种方式不仅能实现低延迟和实时洞察,而且资源消耗大,维护也较为复杂。

详细分解:

1. 数据导入:

- 消息系统: 使用如 Apache Kafka 或 AWS Kinesis 这样的分布式消息系统来接收数据流。它们提供了高吞吐量和容错性。

- 生产者: 应用程序或服务作为生产者,实时发送数据至消息系统。

2. 数据的处理:

- 实时流处理框架: 使用如 Apache Flink、Apache Spark Streaming 或 Kafka Streams 等框架来实时处理数据。

- 数据操作: 对流数据执行各种数据操作,如过滤、聚合、窗口处理和数据丰富。

- 延迟: 尽量减少延迟处理,以确保及时采取行动和获得洞察。

3. 数据存储:

- 实时数据库(如 Apache Cassandra 或 Redis): 将处理后的数据存储在实时数据库中,以便即时检索。

- 数据湖(例如 Amazon S3、Azure 数据湖存储): 将数据存档到数据湖中,以实现长期存储和进一步批处理。

4. 数据使用:

- APIs 和仪表板: 通过 API 提供处理后的数据供下游应用程序使用,或使用诸如 Grafana 或 Tableau 这样的仪表板进行可视化。

- 警报和通知: 根据数据流中的特定条件发送警报或通知。

优势:

- 实时处理: 实现即时数据处理,提供实时洞察。

- 可扩展性: 高度可扩展,能轻松处理大量数据。

- 低延迟: 实现低延迟的数据处理,迅速响应事件。

不足:

- 复杂度: 设计和维护比批处理更复杂。

- 资源密集: 处理实时数据流需要大量资源。

- 一致性: 在分布式实时环境中保持数据一致性具有挑战性。

图:

+------------+ +------------+ +------------+ +------------+

| 数据源系统 | ---> | 消息服务 | ---> | 处理系统 | ---> | 存储服务 |

| | | | | | | |

+------------+ +------------+ +------------+ +------------+

^ ^ ^ ^

| | | |

+---------------------------------------------------------------+

实时数据流动Lambda架构结合了批处理与实时处理,提供了一个全面的数据视图。它提供了容错性和灵活性的特性,但设计和维护较为复杂,操作起来也较为繁琐,并且在批处理层可能会出现潜在的延迟。

详细拆解:

如下:

1. 批处理层阶段:

- 处理大量历史数据: 处理大量历史数据时,可以使用像Apache Hadoop或Apache Spark这样的批处理框架。

- 定期批处理作业: 定期运行批处理作业来处理和汇总数据。

- 存储数据: 将处理后的数据定期存储到数据仓库或数据湖中。

2. 速度层:

- 实时数据处理:使用像Apache Storm或Apache Flink这样的流处理框架来处理实时数据。

- 确保低延迟处理,以提供即时见解。

- 将处理后的实时数据存储在实时数据库系统中,以便快速访问。

3. 服务层:

- 统一视角: 合并批处理层和速度层的结果,提供统一的数据视图。

- 数据访问: 提供统一数据的访问,用于分析、报告等用途。

福利:

- 全面处理: 结合了批处理和实时处理,让你能够全面查看数据。

- 容错性: 由于批处理和实时层的分离,系统具有很高的容错性。

- 灵活性: 灵活的架构能够处理各种数据处理需求,非常方便。

缺点:,

- 复杂度: 由于采用了双层架构,设计和维护变得更加复杂。

- 资源消耗: 资源消耗较大,支持批处理和实时处理。

- 延迟: 批处理层对历史数据造成了延迟。

图:

+------------+ +-------------+ +-------------+

| 批处理数据层 | ---> | 实时数据处理层 | ---> | 统一视图层 |

+------------+ +-------------+ +-------------+

+-------------+

| 批处理数据存储层 |

+-------------+Kappa 架构通过将实时和历史数据都视为流来简化数据处理。它支持实时处理并具备可扩展性,但确保数据一致性和重新处理可能比较复杂。

详细说明:

1. 数据导入:

- 消息系统: 使用如 Apache Kafka 这样的分布式消息系统来接收和处理数据流。这充当了中央数据处理中心的角色。

- 生产者: 应用程序和服务实时地将数据发送到消息系统。

2. 数据处理:

- 流处理框架(如 Apache Flink 或 Apache Spark Streaming): 使用这些框架来实时处理数据。

- 统一处理: 将实时流数据和历史数据都当作流来处理。如有需要,可以将历史数据重处理为流。

- 操作: 可执行各种操作,如过滤、转换、聚合和丰富化等,来处理流数据。

3. 数据存储。

- 实时数据存储: 将处理过的数据实时存储在如 Apache Cassandra 或 Elasticsearch 这样的数据库中。

- 数据湖: 将数据存入数据湖,以进行长期存储和进一步的批处理。

好处如下:

- 简化架构: 通过使用单一的数据处理管道来简化架构。

- 实时处理: 实现了即时的数据处理,让洞察变得即时。

- 可扩展性: 高度可扩展,能够轻松应对大量数据。

不足:

- 复杂度: 确保数据一致性和处理重处理可能很复杂。

- 需要大量资源: 处理实时数据需要大量资源。

- 批处理支持有限: 不太适合处理传统的批量数据需求。

- 批处理支持有限: 批处理支持有限,不太适合处理大批量数据。

示意图

+------------+ +------------+ +------------+

| 数据源 | ---> | 消息传递系统| ---> | 处理系统 |

+------------+ +------------+ +------------+数据湖架构会以原始格式存储原始数据,提供了不同数据类型的高可扩展性和灵活性。它既支持批处理也支持流处理,但管理和确保数据质量和性能可能较为复杂,这需要更多的人力和技术支持。

细节说明:

1. 数据导入:

- 源系统连接: 连接各种源系统以获取原始数据。

- 数据采集工具: 使用Apache NiFi、AWS Glue或自定义脚本等工具来采集数据放入数据湖中。

- 存储: 以原始格式将原始数据存储在数据湖中,例如Amazon S3或Azure Data Lake Storage。

2. 数据保存:

- 数据格式: 使用支持高效存储和查询的格式存储数据(例如 Parquet、ORC、Avro)。

- 读时模式: 在读取数据时定义模式。

- 数据组织: 按照业务逻辑将数据组织成目录和分区。

第三点:数据处理工作:

- 批处理: 使用像 Apache Spark 或 Apache Hive 这样的批处理工具来处理数据。

- 流处理: 使用流处理框架来实时处理数据。

- 数据转换: 根据需要进行数据清洗、转换和丰富。

4. 数据使用:

- 数据访问: 提供处理后的数据,用于分析、机器学习及其他应用场景。

- APIs和BI工具: 通过APIs公开数据,或使用业务智能工具(例如Tableau、Power BI)进行数据的可视化展示和分析。

- 数据治理: 实施数据治理以确保数据的质量、安全性和合规性。

好处:

- 可扩展性: 高度可扩展,可以存储大量的结构化和非结构化数据。

- 灵活性: 让你能够自由地探索、分析和进行机器学习。

- 成本效益: 存储大量数据时成本低廉。

不足:

- 复杂性: 管理和维护起来可能比较复杂。

- 数据质量: 确保数据质量和一致性可能比较困难。

- 性能: 查询性能可能没有数据仓库那么快。

图:

+------------+ +------------+ +------------+ +------------+

| 数据源 | ---> | 数据湖泊 | ---> | 处理流程 | ---> | 数据使用者 |

| | | | | | | |

+------------+ +------------+ +------------+ +------------+

^ ^ ^ ^

| | | |

+---------------------------------------------------------------+

集中数据存储基于微服务的流水线涉及独立的微服务处理特定的数据处理任务,提供可扩展性和故障隔离。这种方法支持模块化开发和系统的韧性,但是这种设计和管理可能会更加复杂,并且可能存在服务间通信的延迟。

分解详情:

1. 数据导入:

- 微服务: 每个微服务负责从特定的源系统获取数据。

- API网关: 使用API网关来管理和路由请求至相应的微服务。

- 可扩展性: 微服务可以根据数据摄入负载独立进行扩展。

2. 数据处理,

- 微服务架构: 每个微服务独立地执行特定的数据转换和处理任务,

- 通信: 微服务之间使用异步通信(例如,消息队列)进行数据处理。

- 故障隔离: 某个微服务中的故障不会影响其他微服务,确保系统的弹性。

3. 数据存储如下:

- 多数据库持久化: 使用针对特定类型数据优化的各种数据库或数据存储(例如,关系型数据库,NoSQL数据库,时序数据库)。

- 数据分区: 将数据拆分存储在多个数据库中以提高性能并增强可管理性。

4. 数据使用:

- APIs: 通过API公开处理过的数据,供下游应用和服务调用。

- 事件驱动架构: 根据数据变化触发事件,并通知相关系统或服务。

- 数据可视化: 使用仪表板和可视化工具向最终用户展示数据洞察。

好处:

- 可扩展性: 具有高度的可扩展性,能够处理大量数据。

- 模块化: 微服务可以独立开发、部署和扩展,保持灵活性。

- 弹性: 即使一个微服务出现故障,也不会影响其他微服务,从而确保系统的高可用性。

不足:

- 复杂性: 由于微服务的分布式特性,设计和管理更加复杂。

- 一致性: 保持数据一致性可能比较困难。

- 延迟: 服务间的通信可能会导致延迟。

图:

+------------+ +--------------+ +--------------+ +--------------+

| 数据源系统 | ---> | 数据摄入微服务 | ---> | 数据处理微服务 | ---> | 数据存储系统 |

+------------+ +--------------+ +--------------+ +--------------+

^ ^ ^ ^

| | | |

+---------------------------------------------------------------+

微服务管道总之,各种数据工程管道设计,包括 ETL、ELT、流处理、Lambda 架构、Kappa 架构、数据湖架构和基于微服务的管道,提供了不同的方法来处理数据摄入量、处理、存储和消费。每种架构都有其独特的优缺点,适用于不同的应用场景。通过了解这些设计,组织可以选择符合其数据处理需求的合适管道策略,确保其数据工作流程的可扩展性、灵活性和高效性。

随时随地看视频

随时随地看视频