在上一篇帖子中,我描述了AI工具如何极大地改变了我的开发工作流程。在帖子的最后,我分享了如何在本地机器上部署Meta Llama LLM的一步一步教程。

因为它位于博文的最末尾,我想分步骤做一个博客,很多人都觉得这很有价值。

瞅瞅吧!

如何在本地运行我自己的AI聊天机器人让我给您简单介绍一下我开始使用Llama(一个开源AI模型)以及其他类似模型的几个简单步骤。

第一步:在您的本地机器上下载并安装 Ollama

访问 官方 Ollama 网站 并快速下载适用于 Windows、Mac 或 Linux 版本的 Ollama 软件。

Ollama 是一个轻量级的工具,允许你在本地电脑上运行大型语言模型(例如 Llama 3.2、Mistral 和 Gemma 2 模型)。安装完成后,你就可以在本地电脑上运行和自定义这些模型。

如图所示:

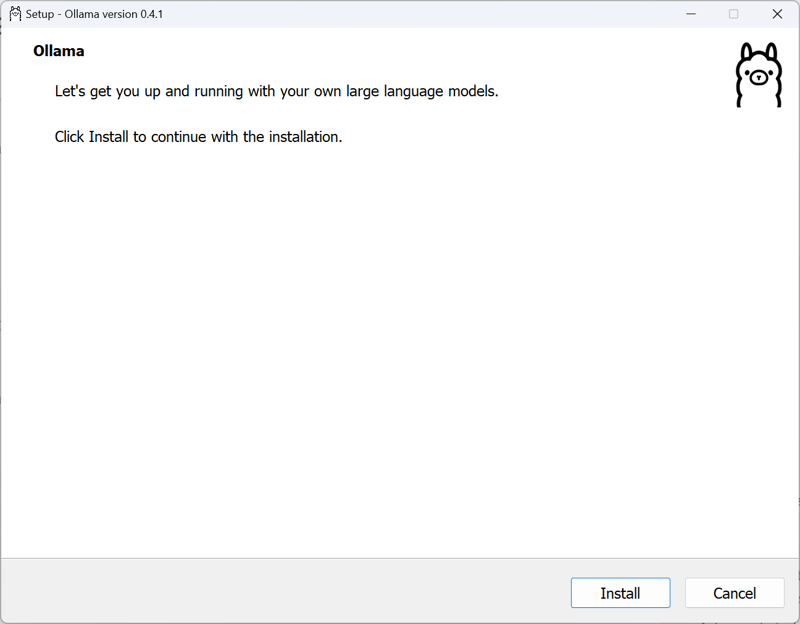

步骤 2:运行 Ollama 设置向导,

下载完成后,打开 Ollama Setup 可执行文件,然后按照向导一步步操作,就可以安装 Ollama 工具了。

正如你所料,Ollama的设置向导会快速添加所有必要的文件,以便你可以运行Ollama工具。

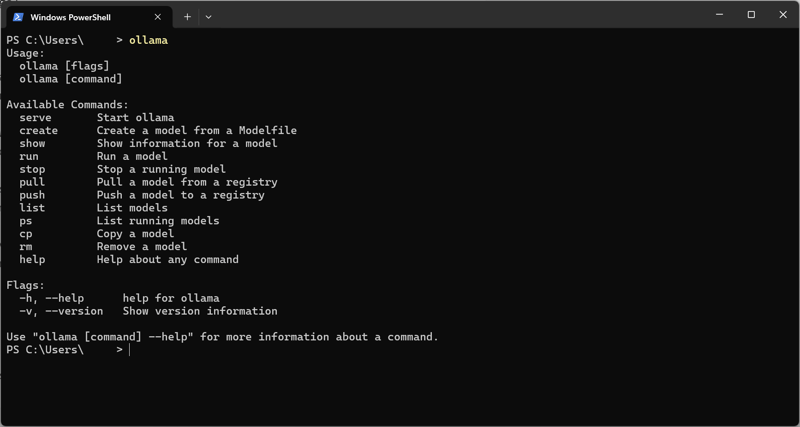

第三步:验证 Ollama 是否已安装

如果 Ollama 安装正确,你应该现在就能从你的标准命令行中访问它。

在安装 Ollama 时,有时它会自动打开一个命令行窗口。如果没有自动打开,你需要自己打开它。

在 Windows 上,查找“cmd”,你应该能够打开命令行。

打开之后,输入以下命令并按Enter键来验证安装:

ollama切换到全屏模式/退出全屏

你应该看到类似下面这样的输出:

用法:

ollama [选项]

ollama [命令]

可用命令:

serve 启动服务

create 从 Modelfile 创建一个模型

show 显示信息

run 运行模型

stop 停止正在运行的模型

pull 从注册表拉取一个模型

push 将模型推送到注册表

list 列出模型

ps 查看运行中的模型

cp 复制一个模型

rm 移除模型

help 命令帮助

选项:

-h, --help 显示 ollama 帮助信息

-v, --version 显示版本信息

如需更多信息,请使用 "ollama [命令] --help"。进入全屏模式,退出全屏模式

如图所示:

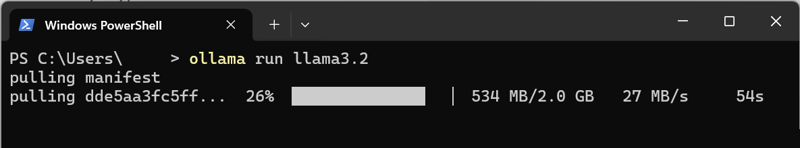

第四步:安装并运行一个大型语言模型:

安装了 Ollama,我们就离拥有自己的本地 LLM 只差一步了。

首先,让我们来安装Meta的_Llama3.2模型吧。

在命令行中键入如下内容:

ollama run llama3.2

//这是运行llama3.2的命令切换到全屏 退出全屏

这会做两件事:

- 如果没有安装Llama3.2,请先安装它

- 运行Llama3.2

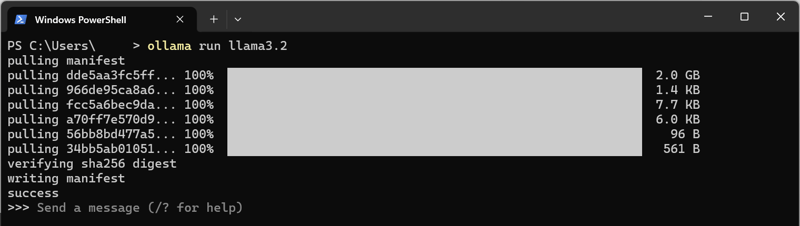

按下回车键/Enter键,你应该会看到类似这样的界面(如果Llama3.2没有安装)。

正在拉取 manifest

正在拉取 dde5aa3fc5ff... 26% ▕████████████ ▏ 532 MB/2.0 GB 32 MB/s 48s全屏 退出全屏

Ollama 会为你下载并安装 Llama3.2 模型,安装完成后,然后运行 Llama3.2 模型供你互动体验。

在你的命令行界面中,你应该看到类似下面的样子:

拉取清单文件

拉取 dde5aa3fc5ff... 100% ▕████████████████████████████████████████████████████████▏ 2.0 GB

拉取 966de95ca8a6... 100% ▕████████████████████████████████████████████████████████▏ 1.4 KB

拉取 fcc5a6bec9da... 100% ▕████████████████████████████████████████████████████████▏ 7.7 KB

拉取 a70ff7e570d9... 100% ▕████████████████████████████████████████████████████████▏ 6.0 KB

拉取 56bb8bd477a5... 100% ▕████████████████████████████████████████████████████████▏ 96 字节

校验 sha256 校验和

写入清单文件

成功

>>> 发送消息 (/? 查看帮助)全屏 / 退出全屏

就这样,你现在也有一个LLM在本地机器上了!!

另外,如果你想安装[Ollama提供的其他模型],只需使用相同的命令:

ollama run MODEL_NAME # 运行指定的模型全屏模式 退出全屏

步骤五:试试你的大型语言模型

既然 Llama3.2 已经在我们的机器上了,让我们试一试。

我们来问它个简单的问题吧:

嘿,Llama!你能告诉我一点关于你的事情吗?全屏模式,退出全屏

你应该会收到类似以下的回复:

嘿,羊驼!你可以告诉我一些关于你自己的事情吗?

我很乐意和你聊天。我是一个被称为“羊驼”的人工智能模型,简称“大型语言模型元AI”。我的主要任务是根据接收到的输入来生成类似人类的文字。

我是在大量的文本数据集上训练出来的,这些数据来自各种来源,比如书籍、文章和在线对话。这样的训练让我能够理解和回应各种问题、话题和风格。

我的一些关键功能有:

.....全屏,退出全屏

看!那不是挺容易的吗?

结尾就这样,你的 Llama LLM 应该可以在本地机器上毫不费力地启动并运行起来了。

如果你对了解Ollamas文档感兴趣,可以点击这里查阅:这里

如果你对一个能让你更轻松使用Ollama的GUI感兴趣,可以看看Open Web UI。希望不久后能写一篇详细的博客,介绍如何设置这个GUI。

享受你自己的私人助手吧,一个 llama(羊驼)!

照片顺序(按出现顺序):

封面照片使用Google Gemini

提示:

一只面带自信笑容的羊驼,披着印有无限符号的蓝色斗篷,在日落时分飞翔,准备在插图中拯救世界。

快来关注我的社交媒体:

https://linktr.ee/bradstondev

随时随地看视频

随时随地看视频