我对闭源软件没有好感,尤其是在大语言模型应用开发方面 👎 但值得庆幸的是,对于领域中的每一个闭源框架或工具,都应有一个开源的对应(毕竟,这不就是某个著名科学家所说的第三定律吗🤔)?

所以在这篇文章中,作为一名在大型语言模型开发这个兔子洞 🐇 中泡了两年多的人,我要告诉你五个最重要的开源替代方案,用于封闭源的大型语言模型开发。

来了!🙌

(PS. 请给开源仓库星标,帮助它们获得和闭源仓库一样的关注!)

1. DeepEval 对比 HumanloopDeepEval 是一个开源的 LLM 评估框架 👍,而 Humanloop 则是一个闭源的 LLM 评估工具 👎,它有隐藏的 API,而是隐藏了评估过程,不像开放算法那样透明。

这是最重要的一个,因为在我的看法中,没有什么比公开的LLM评估更重要了 💯。公开性不仅带来了透明度,而尤其是在LLM的开发过程中,这能让每个人都能清楚看到评估的标准。你肯定不希望某些LLM的安全评估是在暗箱操作中进行的,而你只能被动地接受结果吧?

开源代码常常被仔细审查,这让DeepEval比Humanloop更易上手。这里是如何在DeepEval中评估您的LLM应用程序的方法:

from deepeval import evaluate

from deepeval.metrics import AnswerRelevancyMetric

from deepeval.test_case import LLMTestCase

test_case = LLMTestCase(

input="How many evaluation metrics does DeepEval offers?",

actual_output="14+ evaluation metrics"

)

metric = AnswerRelevancyMetric()

evaluate(test_cases=[test_case], metrics=[metric])全屏/退出全屏

……

2. Llama3.1 相比 Open AI 的 GPT-4我敢说你早就猜到了,但接下来要介绍的是Meta的Llama3.1和OpenAI的GPT-4。Llama3.1可以自托管,推理速度更快,成本更低,最棒的是它是开源的,连权重也是公开的。这又代表什么呢?

这意味着如果你想自定义Llama3.1,值得一提的是,它在多个基准测试中表现得和GPT-4一样好,你可以自己动手来定制。Meta投入了数百万(或数十亿?)美元来训练Llama3.1,现在任何人都可以利用这些资源进行微调,享受Meta的投入成果。

今天试试Llama3.1吧

导入 transformers

导入 torch

# 这里我们导入必要的库

model_id = "meta-llama/Llama-3.1-8B"

# pipeline = "文本生成流水线"

pipeline = transformers.pipeline(

"text-generation", model=model_id, model_kwargs={"torch_dtype": torch.bfloat16}, device_map="auto"

)

response = pipeline("你好,今天怎么样?")切换到全屏 退出全屏

……

3. LangChain —— OpenAI 小助手抱歉,OpenAI,又是你。LangChain 是一个 LLM 应用程序编排框架,而 OpenAI 助手则像是一个 RAG API 的形式,内部编排逻辑则隐藏在密闭的门后。

我知道,我在用一些大词,听起来可能有点高大上,但让我解释一下这些术语的意思。LLM编排简单来说就是把外部数据跟你的LLM连接起来,并通过让LLM访问你的API,让它在需要时获取数据。比如,一个基于LangChain的聊天机器人向你报告每日天气,可以让LLM获取今天最新的天气信息。而在OpenAI的工具中,他们把这些功能都隐藏在API后面了。

这意味着它并不那么灵活,说实话,我甚至连一个用这个助手功能的人都没见过,尽管它被炒作得沸沸扬扬成了下一个大事件。

4. Flowise >> 相关的人工智能

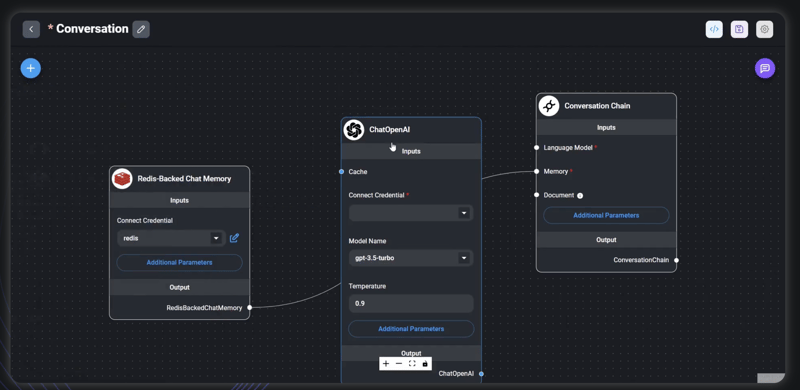

所以 LangChain 允许你通过代码来构建你的 LLM 应用程序。而 Flowise 允许你通过一个开源的 UI 来构建你的 LLM 应用程序。只需点击和拖拽,即可自定义你的 LLM 可访问的数据,基本上就可以用了。

另一种选择是稍微差一点的付费版本。

来看看Flowise:

🌟 GitHub 上给 FlowiseAI/Flowise 点个 Star

5. 轻量级 LLM -> 火星AI

Lite LLM 是一个开源库,它允许你通过一行代码来替换大型语言模型,相比之下,Martian 是它的闭源版本。

其实不是这样,火星AI实际上是个LLM路由器,它能为你的每个输入挑选最适合的LLM,从而优化准确度、速度和成本。

这次真是少见,这两款产品都还不错。

\🌟 在 GitHub 上给 BerriAI/litellm 点个星

火星AI来了https://withmartian.com/

这就给你了,你应该知道的一些开源和闭源LLM开发工具。觉得我漏了什么吗?在下面留言告诉我吧!

感谢大家的阅读,下期见 😊

随时随地看视频

随时随地看视频